Neuronales Netz

Neuronales Netz

Einleitung

Neuronale Netzwerke sind ein zentraler Bestandteil der Künstlichen Intelligenz und Maschinelles Lernen. Sie orientieren sich an der Funktionsweise biologischer Nervensysteme und dienen dazu, komplexe Muster und Zusammenhänge in Daten zu erkennen. Dieser aiMOOC erklärt die Grundlagen, Strukturen und Anwendungen von neuronalen Netzwerken und bietet interaktive Übungen sowie offene Aufgaben, um das Thema praxisnah zu vertiefen.

Grundlagen neuronaler Netzwerke

Was ist ein neuronales Netzwerk?

Ein Neuronales Netzwerk ist ein Modell aus miteinander verbundenen künstlichen Neuronen, die Informationen verarbeiten. Es besteht aus:

- Eingabeschicht: Sie nimmt die Daten auf.

- Verborgene Schichten: Sie verarbeiten die Daten und erkennen Muster.

- Ausgabeschicht: Sie liefert die Ergebnisse.

Funktionsweise

Ein neuronales Netzwerk arbeitet in mehreren Schritten:

- Eingangsdaten werden in die Eingabeschicht eingespeist.

- Diese Daten werden gewichtet und in den Aktivierungsfunktionen der Verborgenen Schichten verarbeitet.

- Am Ende wird das Ergebnis durch die Ausgabeschicht weitergegeben.

Arten von neuronalen Netzwerken

Neuronale Netzwerke haben unterschiedliche Architekturen:

- Feedforward-Netzwerk: Daten fließen nur in eine Richtung.

- Rekurrentes Netzwerk: Daten können rückwärts fließen.

- Convolutional Neural Network (CNN): Spezialisiert auf Bildverarbeitung.

- Generative Adversarial Network (GAN): Erzeugt neue Daten wie Bilder.

Interaktive Aufgaben

Quiz: Teste Dein Wissen

Wie nennt man die Schicht, die Daten in ein neuronales Netzwerk einspeist? (Eingabeschicht) (!Ausgabeschicht) (!Verborgene Schicht) (!Trainingsschicht)

Welche Netzwerke sind speziell für die Bildverarbeitung geeignet? (Convolutional Neural Networks) (!Feedforward-Netzwerke) (!Rekurrente Netzwerke) (!Lineare Netzwerke)

Welche Funktion haben Aktivierungsfunktionen? (Sie entscheiden, ob ein Neuron "aktiviert" wird.) (!Sie speichern Daten.) (!Sie trainieren das Netzwerk.) (!Sie visualisieren Daten.)

Was ist das Ziel des Trainings eines neuronalen Netzwerks? (Das Minimieren des Fehlers.) (!Das Maximieren der Datenmenge.) (!Die Erstellung von mehr Neuronen.) (!Die Veränderung der Netzwerkstruktur.)

Welche Daten fließen durch rekurrente Netzwerke? (Daten können in beide Richtungen fließen.) (!Daten fließen nur vorwärts.) (!Daten werden zwischengespeichert.) (!Daten werden ignoriert.)

Was ist ein Generative Adversarial Network (GAN)? (Ein Netzwerk, das neue Daten generiert.) (!Ein Netzwerk zur Fehlerkorrektur.) (!Ein Netzwerk für lineare Regression.) (!Ein Netzwerk zur Textverarbeitung.)

Welche Schicht kommt nach der Eingabeschicht? (Verborgene Schicht) (!Ausgabeschicht) (!Datenbank) (!Aktivierungsschicht)

Welche Anwendung nutzen Convolutional Neural Networks (CNNs)? (Bildklassifikation) (!Sprachübersetzung) (!Textgenerierung) (!Zeitreihenanalyse)

Was bedeutet "Training" in neuronalen Netzwerken? (Anpassen der Gewichte.) (!Erstellen neuer Neuronen.) (!Visualisieren der Schichten.) (!Speichern der Daten.)

Welche Art von Netzwerk eignet sich für Zeitreihenanalysen? (Rekurrentes Netzwerk) (!Feedforward-Netzwerk) (!Convolutional Neural Network) (!Generative Adversarial Network)

Memory

| Neuron | Verarbeiten von Informationen |

| Eingabeschicht | Aufnahme von Daten |

| Aktivierungsfunktion | Entscheidung der Neuronaktivierung |

| CNN | Bildverarbeitung |

| GAN | Erzeugung neuer Daten |

Kreuzworträtsel

| NeuronalesNetzwerk | Wie nennt man künstlich aufgebaute Systeme nach dem Vorbild des Gehirns? |

| Aktivierung | Was entscheidet, ob ein Neuron Daten weitergibt? |

| CNN | Welches Netzwerk wird für Bildanalysen verwendet? |

| GAN | Wie heißt ein Netzwerk, das neue Bilder erzeugt? |

| Rekurrent | Welche Netzwerke analysieren Zeitreihen? |

| Trainingsdaten | Was benötigt ein Netzwerk, um Muster zu lernen? |

LearningApps

Lückentext

Offene Aufgaben

Leicht

- Erstelle eine Definition für neuronale Netzwerke.

- Zeichne ein Schema eines neuronalen Netzwerks.

- Beschreibe in einfachen Worten die Funktionsweise von neuronalen Netzwerken.

Standard

- Vergleiche verschiedene Arten von neuronalen Netzwerken.

- Untersuche Anwendungen von CNNs in der Praxis.

- Finde Beispiele für GANs in der Bildgenerierung.

Schwer

- Programmiere ein einfaches neuronales Netzwerk mit Python.

- Analysiere Vor- und Nachteile von neuronalen Netzwerken.

- Entwickle ein eigenes Projekt basierend auf einem rekurrenten Netzwerk.

Lernkontrolle

- Erkläre den Zusammenhang zwischen Aktivierungsfunktion und Lernprozess.

- Diskutiere ethische Fragen bei der Nutzung von neuronalen Netzwerken.

- Beschreibe mögliche Schwächen eines neuronalen Netzwerks.

- Vergleiche biologisches und künstliches Lernen.

- Erörtere die Zukunftsaussichten für neuronale Netzwerke.

OERs zum Thema

Medien

Links

Neuronales Netz

Einleitung

Willkommen zum aiMOOC Neuronales Netz! In diesem Kurs lernst Du, wie Künstliche Intelligenz mit künstlichen neuronalen Netzen arbeitet, welche Grundlagen wichtig sind und wie Verfahren wie Backpropagation, Gradientenabstieg oder Aktivierungsfunktionen funktionieren. Du erfährst, wie Deep Learning-Modelle wie Convolutional Neural Networks (CNN), Rekurrente neuronale Netze (RNN), LSTM und Transformer aufgebaut sind und wo sie in Bilderkennung, Spracherkennung, Übersetzung oder medizinischer Diagnostik eingesetzt werden.

Dieser aiMOOC liefert Dir Erklärtexte, interaktive Aufgaben, ein Quiz, ein Kreuzworträtsel, Memory und viele weiterführende Links. Du kannst die Inhalte in der Schule nutzen, zur Prüfungsvorbereitung oder für eigene Projekte.

Was ist ein neuronales Netz?

Ein neuronales Netz ist ein Rechenmodell, das grob an biologische Neuronen angelehnt ist. Es besteht aus Schichten (engl. Layers) mit vielen Knoten (Neuronen), die über Gewichte verbunden sind. Jede Verbindung trägt eine Zahl (Gewicht), die beeinflusst, wie stark ein Signal weitergegeben wird. Ein Bias verschiebt die Aktivierung. Die Ausgabe eines Neurons ergibt sich aus einer gewichteten Summe der Eingaben plus Bias, gefolgt von einer Aktivierungsfunktion wie Sigmoid, Tanh oder ReLU.

Historische Entwicklung

- McCulloch & Pitts (1943): Formales Neuron-Modell.

- Perceptron (1958): Frühes lernfähiges Modell.

- Backpropagation (1986): Effizientes Training mehrschichtiger Netze.

- CNN (1989–1998): Erfolge in Vision.

- Deep Learning (ab 2012): Leistungsdurchbruch dank GPU-Rechenleistung, großer Daten und besserer Optimierung.

- Transformer (2017): Attention ersetzt viele rekurrente Strukturen.

Mathematische Grundlagen

Ein Feedforward-Netz berechnet in jeder Schicht z = W·x + b und a = φ(z), wobei W die Gewichtsmatrix, b der Bias und φ die Aktivierungsfunktion ist. Beim Training minimierst Du eine Kosten- bzw. Verlustfunktion (z. B. MSE oder Kreuzentropie) mittels Gradienten und Gradientenabstieg. Backpropagation nutzt die Kettenregel der Differentialrechnung, um die Gradienten effizient durch das Netz zu berechnen.

Architekturen

- Perceptron: Einfachstes lineares Klassifikations-Modell.

- Mehrschichtiges Perzeptron (MLP): Mehrere verborgene Schichten.

- CNN: Faltungen für Bildverarbeitung.

- RNN, LSTM, GRU: Sequenzen und Zeitreihen.

- Autoencoder & VAE: Kompression/Generieren.

- GAN: Generator und Diskriminator im Wettbewerb.

- Transformer: Self-Attention für NLP, Vision und Multimodalität.

Training, Regularisierung und Optimierung

- Backpropagation & Optimierer: SGD, Momentum, RMSProp, Adam.

- Regularisierung: L1, L2, Dropout, Early Stopping, Datenaugmentation.

- Lernrate & Sheduling: Warmup, Cosine.

- Batch-Normierung: BatchNorm, LayerNorm.

Überwachtes, unüberwachtes und bestärkendes Lernen

- Überwachtes Lernen: Klassifikation, Regression.

- Unüberwachtes Lernen: Clustering, Reduktion.

- Bestärkendes Lernen (RL): Agent maximiert Belohnung mittels Policy und Wertfunktionen.

Anwendungen

- Bild- und Objekterkennung (z. B. CNNs).

- Sprach- und Audioverarbeitung (RNN/LSTM, Transformer).

- Übersetzung & Textverständnis.

- Empfehlungssysteme.

- Diagnostik, Autonomes Fahren, Forecasting.

- Erklärbarkeit & Ethik: Bias, Fairness, Transparenz.

Interaktive Aufgaben

Quiz: Teste Dein Wissen

Woraus besteht die Grundoperation eines künstlichen Neurons? (Gewichtete Summe plus Bias und Aktivierungsfunktion) (!Nur eine logische UND-Verknüpfung) (!Eine feste Tabelle mit Ausgaben ohne Gewichte) (!Zufällige Ausgabe ohne Eingaben)

Welche Funktion minimiert man beim Training? (Die Verlust- bzw. Kostenfunktion) (!Die Aktivierungsfunktion) (!Die Normalisierungsfunktion) (!Die Zufallsfunktion)

Wofür steht die Abkürzung CNN? (Convolutional Neural Network) (!Conditional Numeric Network) (!Central Neural Node) (!Convergent Neuron Net)

Welche Methode berechnet Gradienten effizient durch alle Schichten? (Backpropagation) (!Forward Sampling) (!Principal Component Analysis) (!K-Means)

Welche Aktivierungsfunktion ist stückweise linear und oft in Deep Learning verwendet? (ReLU) (!Softmax) (!Sigmoid) (!Gauß)

Welches Verfahren gehört zur Regularisierung? (Dropout) (!Max-Pooling) (!Softmax) (!Batching)

Welche Architektur eignet sich besonders für Sequenzen? (LSTM) (!Perceptron) (!Radial Basis Function) (!K-Means-Netz)

Was bewirkt die Lernrate beim Gradientenabstieg? (Sie bestimmt die Schrittweite der Gewichtsaktualisierung) (!Sie legt die Anzahl der Schichten fest) (!Sie wählt die Aktivierungsfunktion) (!Sie erzeugt neue Trainingsdaten)

Was ist der Zweck von Softmax in der Klassifikation? (Normalisierung zu Wahrscheinlichkeiten über Klassen) (!Verkürzung der Trainingszeit durch Pruning) (!Ersetzen von Convolutions) (!Reduktion der Eingabedimension)

Welches Konzept steht im Zentrum von Transformern? (Self-Attention) (!Gewichts-Sharing über Convolutions) (!Zeitverzögerte Rekurrenz) (!Reinforcement Belohnung)

Memory

| Perceptron | Frühes lineares Klassifikationsmodell |

| Backpropagation | Gradientenberechnung mit Kettenregel |

| ReLU | Stückweise lineare Aktivierung |

| CNN | Faltungen für Bilderkennung |

| LSTM | Gedächtniszellen für Sequenzen |

| Softmax | Wahrscheinlichkeitsverteilung über Klassen |

Drag and Drop

| Ordne die richtigen Begriffe zu. | Meilensteine neuronaler Netze (chronologisch) |

|---|---|

| McCulloch-Pitts | 1 |

| Perceptron | 2 |

| Backpropagation | 3 |

| AlexNet | 4 |

| Transformer | 5 |

...

Kreuzworträtsel

| Perceptron | Einfachstes Neuronmodell zur Klassifikation? |

| Backpropagation | Wie heißt das Standardverfahren zur Gradientenberechnung? |

| Synapse | Wie nennt man die Verbindungsstelle zwischen Neuronen (biologisch)? |

| Gradienten | Welche Größen werden beim Abstieg berechnet und genutzt? |

| Aktivierung | Wie heißt die Ausgabe nach der Nichtlinearität? |

| Transformer | Welche Architektur nutzt Self-Attention zentral? |

LearningApps

Lückentext

Offene Aufgaben

Leicht

- Begriffe sammeln: Erstelle ein Glossar mit mindestens 15 Begriffen (z. B. Neuron, Gewicht, ReLU, Softmax) und kurzen Erklärungen.

- Skizze zeichnen: Zeichne ein einfaches MLP mit Eingabe-, verborgenen und Ausgabeschichten.

- Anwendungen recherchieren: Finde fünf reale Anwendungen von neuronalen Netzen in Deinem Alltag.

Standard

- Mini-Experiment: Simuliere per Tabellenkalkulation ein Perceptron für eine ODER-Logik. Dokumentiere die Gewichte und Ergebnisse.

- Datenethik: Analysiere, wo Bias in Trainingsdaten entstehen kann, und formuliere Gegenmaßnahmen.

- Architekturvergleich: Vergleiche CNN, RNN/LSTM und Transformer hinsichtlich Stärken/Schwächen.

Schwer

- Kleines Projekt: Implementiere ein MLP zur Klassifikation eines kleinen Datensatzes (z. B. Iris). Erkläre Train/Validation/Test.

- Hyperparameter-Studie: Untersuche Einfluss von Lernrate, Batchgröße und Epochen auf die Generalisation.

- Erklärbarkeit: Wende einfache XAI-Methoden (z. B. Saliency) auf ein Bildklassifikationsmodell an.

Lernkontrolle

- Übertrage Konzepte: Erkläre, wie Du ein CNN für Audio anpassen würdest – welche Schritte und warum?

- Vergleiche Verfahren: In welchem Szenario ist Transformer einem LSTM überlegen – begründe fachlich.

- Regularisierung planen: Entwirf einen Regularisierungsplan für ein überanpassendes Modell (Konzept, nicht Code).

- Fehler analysieren: Ein Modell ist stabil im Training aber schlecht auf Testdaten – welche Ursachen, welche Maßnahmen?

- Metriken wählen: Welche Metriken nutzt Du für ein unausgewogenes Klassifikationsproblem und warum?

OERs zum Thema

Medien

Links

Teilen - Diskussion - Bewerten

Schulfach+

aiMOOCs

aiMOOC Projekte

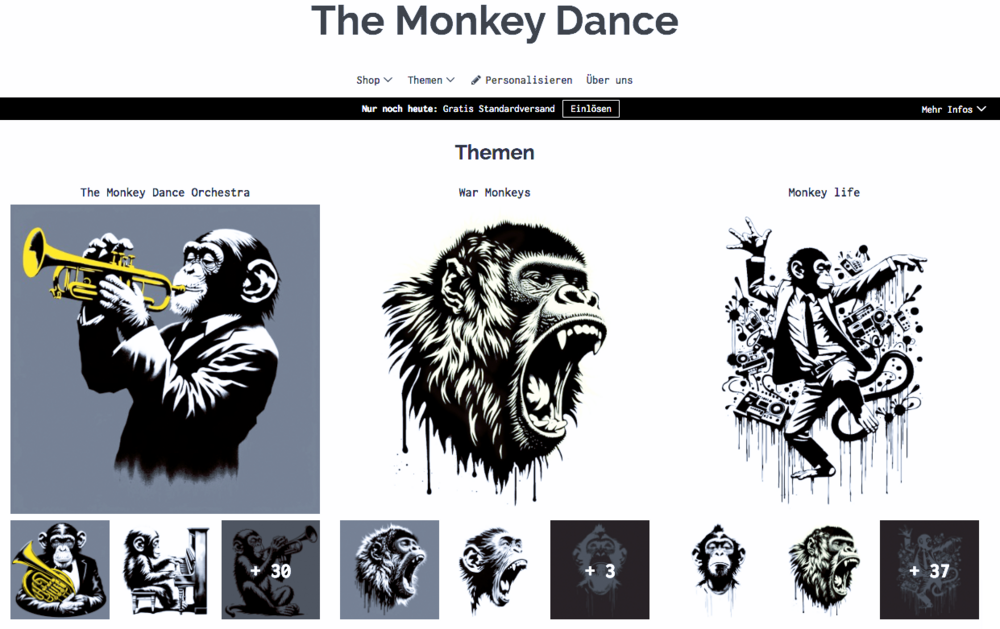

THE MONKEY DANCE

|

|

|

Sponsoren, Förderer, Kooperationspartner

Children for a better world >> Förderung der AI Fair-Image Challenge

Fair-Image wird von CHILDREN JUGEND HILFT! gefördert und ist mit der deutschlandweiten AI Fair-Image Challenge SIEGERPROJEKT 2025. Alle Infos zur Challenge hier >>. Infos zum Camp25 gibt es hier. Wenn auch Ihr Euch ehrenamtlich engagiert und noch finanzielle Unterstützung für Eurer Projekt braucht, dann stellt gerne einen Antrag bei JUGEND HILFT.