FELIX: Unterschied zwischen den Versionen

Glanz (Diskussion | Beiträge) Keine Bearbeitungszusammenfassung |

Glanz (Diskussion | Beiträge) Keine Bearbeitungszusammenfassung |

||

| (9 dazwischenliegende Versionen desselben Benutzers werden nicht angezeigt) | |||

| Zeile 3: | Zeile 3: | ||

{{:MOOCit - Titel}} | {{:MOOCit - Titel}} | ||

<br> | |||

{{#ev:youtube | https://www.youtube.com/watch?v=RWUlCLrc-wU | 700 | center}} | |||

<br> | |||

= '''FELIX – Feedbackkultur mit KI''' = | = '''FELIX – Feedbackkultur mit KI''' = | ||

== Vorwort == | == Vorwort == | ||

| Zeile 12: | Zeile 14: | ||

Dieses Buch entfaltet mit '''FELIX''' und der Kurzform '''FIX''' eine wissenschaftlich begründete, praxistaugliche Architektur für Feedbackkultur im Zeitalter der Künstlichen Intelligenz (KI). Im Zentrum steht Lernen als sozial eingebetteter, kognitiv anspruchsvoller und zielgerichteter Prozess, der durch geeignete Rückmeldungen sichtbar, steuerbar und nachhaltig wird. Forschung zu formativer Beurteilung und Feedback zeigt konsistent: Rückmeldungen sind dann wirksam, wenn sie früh ansetzen, an expliziten Zielen ausgerichtet sind, sich auf beobachtbare Merkmale beziehen, handlungsleitend formuliert sind und zeitnah in Überarbeitung münden.<ref>Black, P.; Wiliam, D. (1998): Assessment and Classroom Learning. ''Assessment in Education'', 5(1), 7–74.</ref><ref>Hattie, J.; Timperley, H. (2007): The Power of Feedback. ''Review of Educational Research'', 77(1), 81–112.</ref><ref>Shute, V. J. (2008): Focus on Formative Feedback. ''Review of Educational Research'', 78(1), 153–189.</ref> | Dieses Buch entfaltet mit '''FELIX''' und der Kurzform '''FIX''' eine wissenschaftlich begründete, praxistaugliche Architektur für Feedbackkultur im Zeitalter der Künstlichen Intelligenz (KI). Im Zentrum steht Lernen als sozial eingebetteter, kognitiv anspruchsvoller und zielgerichteter Prozess, der durch geeignete Rückmeldungen sichtbar, steuerbar und nachhaltig wird. Forschung zu formativer Beurteilung und Feedback zeigt konsistent: Rückmeldungen sind dann wirksam, wenn sie früh ansetzen, an expliziten Zielen ausgerichtet sind, sich auf beobachtbare Merkmale beziehen, handlungsleitend formuliert sind und zeitnah in Überarbeitung münden.<ref>Black, P.; Wiliam, D. (1998): Assessment and Classroom Learning. ''Assessment in Education'', 5(1), 7–74.</ref><ref>Hattie, J.; Timperley, H. (2007): The Power of Feedback. ''Review of Educational Research'', 77(1), 81–112.</ref><ref>Shute, V. J. (2008): Focus on Formative Feedback. ''Review of Educational Research'', 78(1), 153–189.</ref> | ||

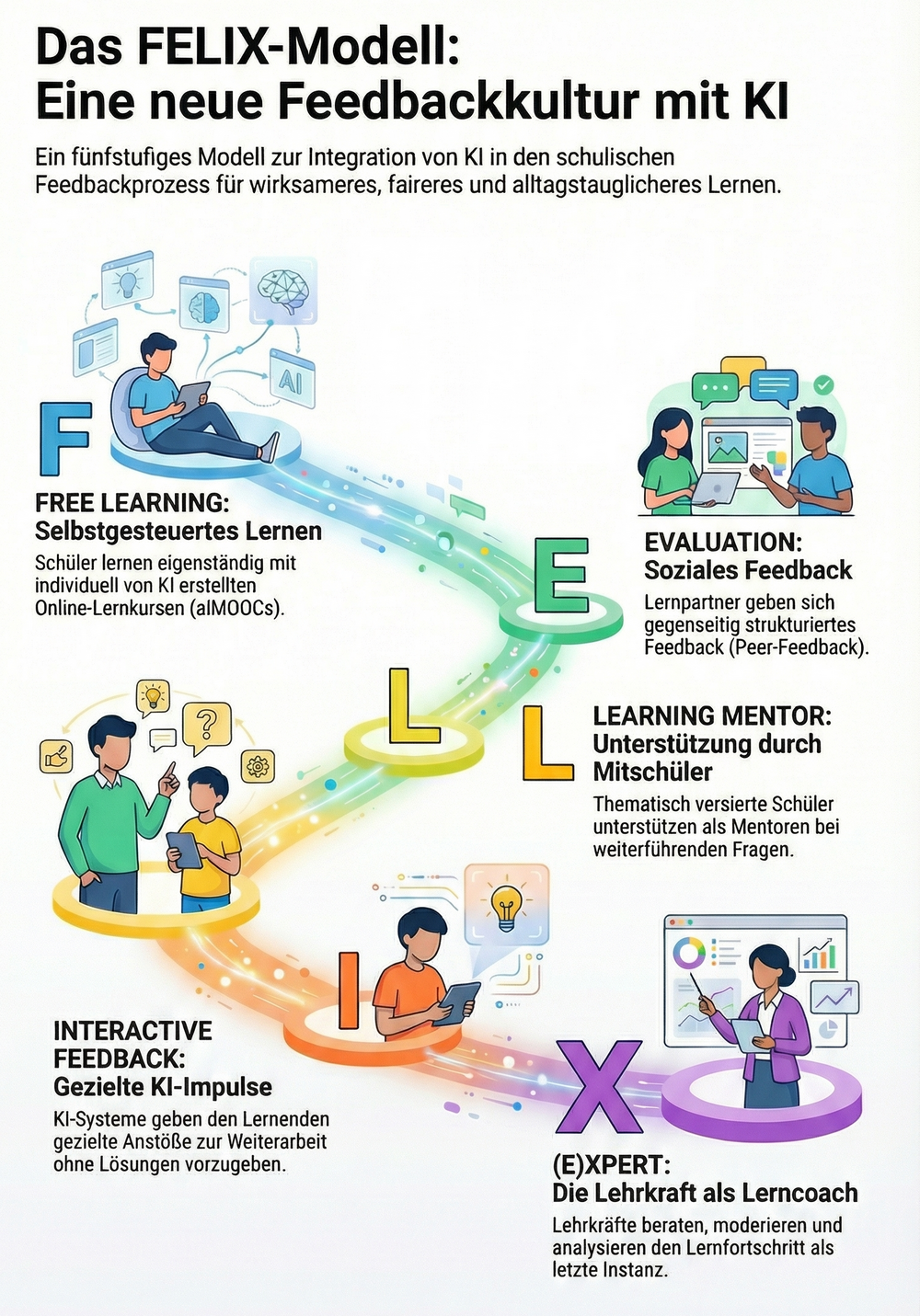

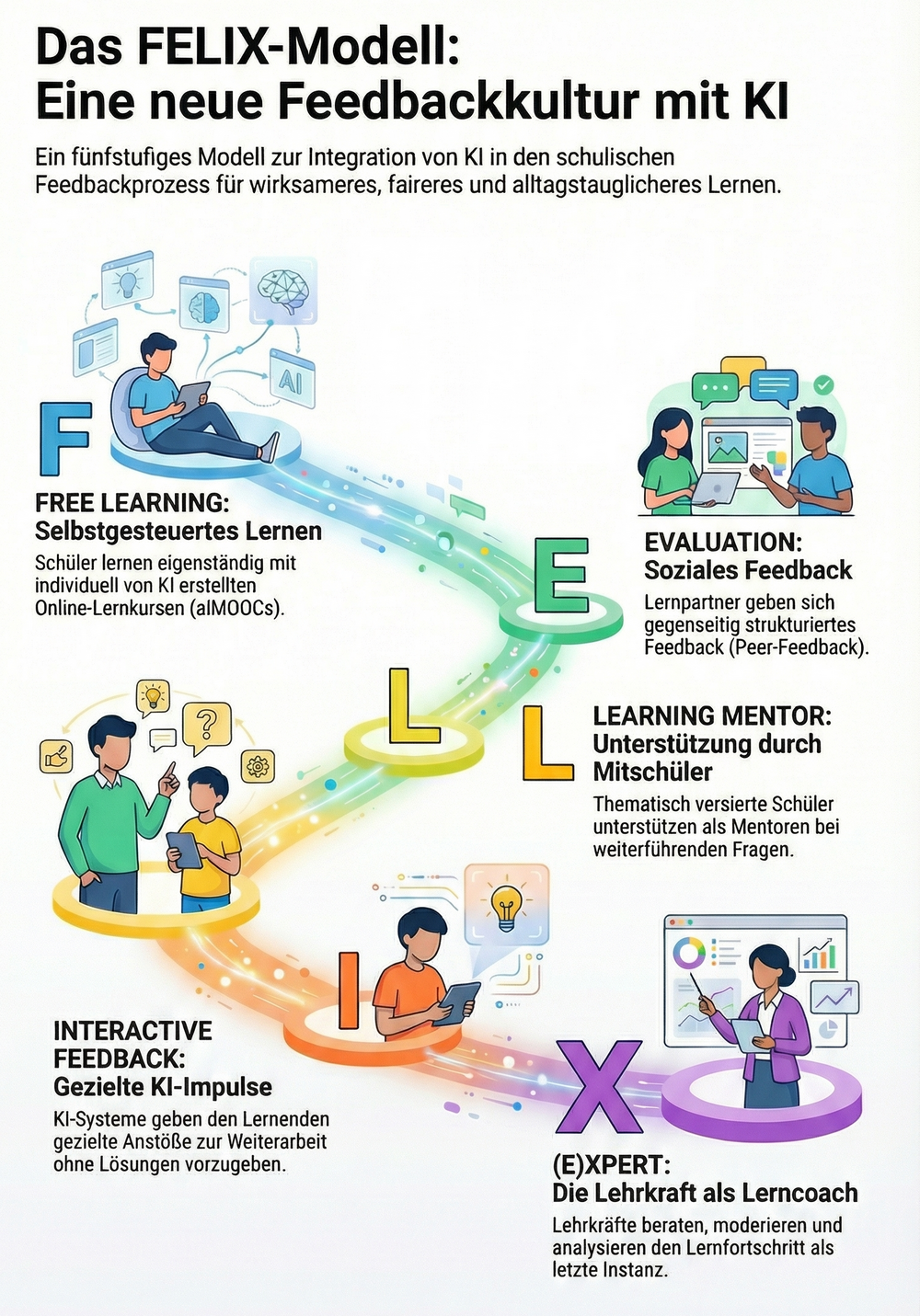

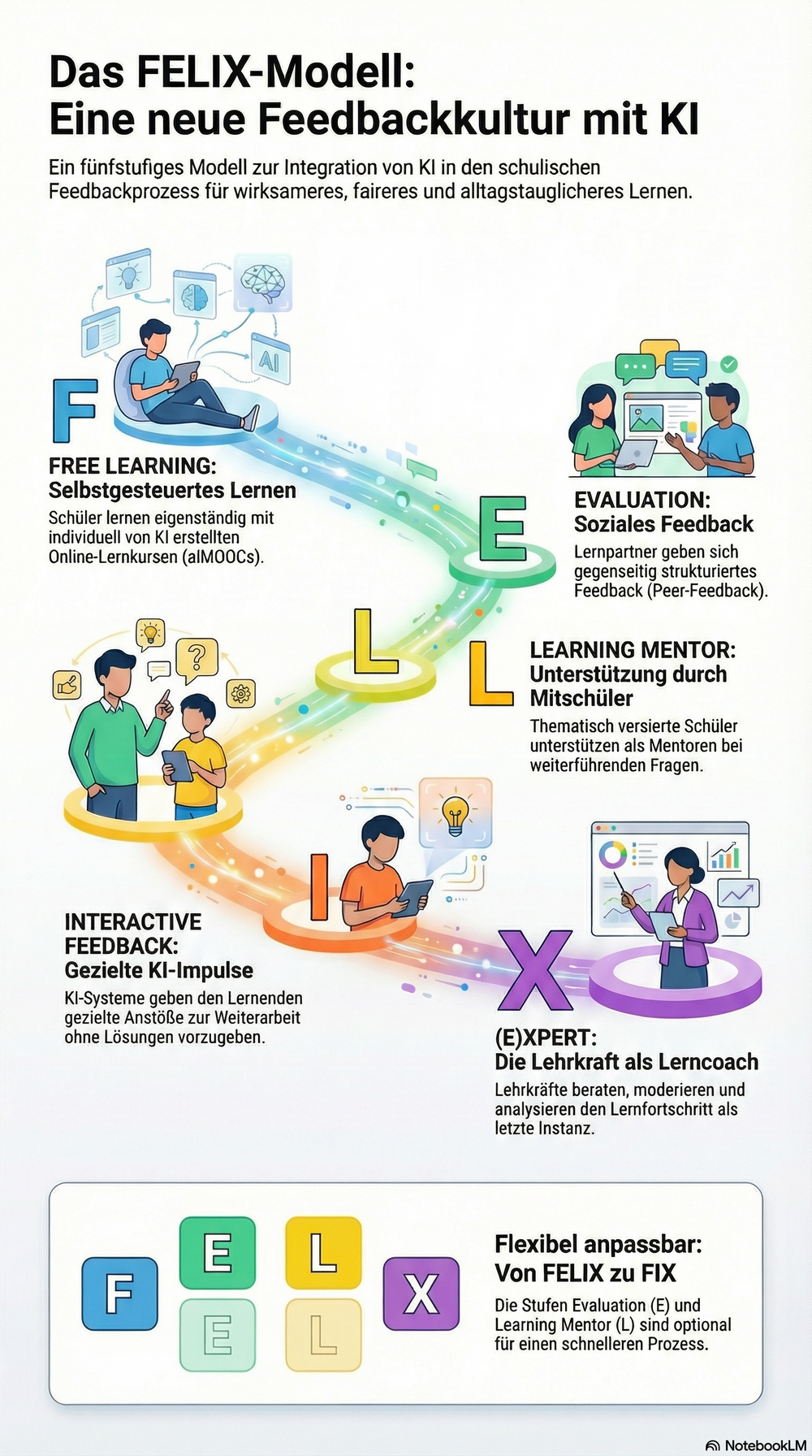

'''FELIX''' beschreibt fünf ineinandergreifende Stufen: '''Free Learning''' (strukturierte Lernumgebungen mit Sofort-Rückmeldung), '''Evaluation''' (Peer-Feedback), '''Learning Mentor''' (gezielte Expertenstütze), '''Interactive Feedback''' (KI-gestützte Impulse) und '''Xpert''' (reflektierende Lehrkraft). '''FIX''' ist die pragmatische Kurzform ohne E und L, wenn Peer- oder Mentorenstrukturen situativ fehlen. Der Name '''FELIX''' verweist etymologisch auf ''felix'' = der Glückliche/Erfolgreiche/Fruchtbare und steht sinnbildlich für eine Lernkultur, die Freude, Wirksamkeit und Wachstum ermöglicht. | '''FELIX''' beschreibt fünf ineinandergreifende Stufen: | ||

# '''Free Learning''' (strukturierte Lernumgebungen mit Sofort-Rückmeldung), | |||

# '''Evaluation''' (Peer-Feedback), | |||

# '''Learning Mentor''' (gezielte Expertenstütze), | |||

# '''Interactive Feedback''' (KI-gestützte Impulse) und | |||

# '''(E)Xpert''' (reflektierende Lehrkraft). | |||

{{#ev:youtube | https://www.youtube.com/watch?v=yrBK1tvEDfk| 500 | center}} | |||

[[Datei:FELIX - Die Feedbackkultur mit KI.png|1000px|rahmenlos|zentriert]] | |||

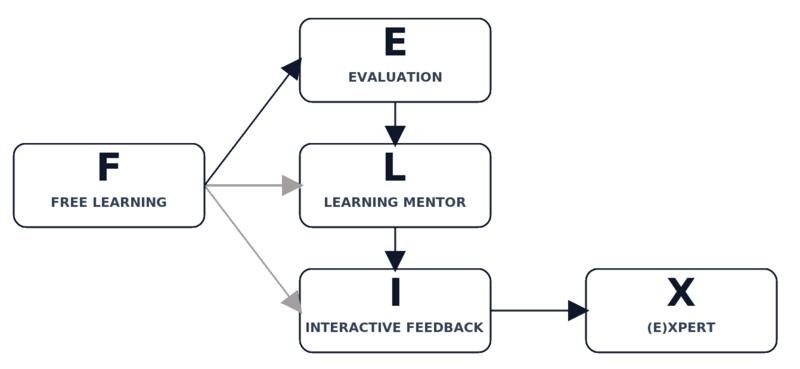

'''FIX''' ist die pragmatische Kurzform ohne E und L, wenn Peer- oder Mentorenstrukturen situativ fehlen. Der Name '''FELIX''' verweist etymologisch auf ''felix'' = der Glückliche/Erfolgreiche/Fruchtbare und steht sinnbildlich für eine Lernkultur, die Freude, Wirksamkeit und Wachstum ermöglicht. | |||

KI wird in diesem Rahmen als '''Verstärker''' genutzt, nicht als Ersatz pädagogischer Professionalität. Sie kann Fehlermuster identifizieren, Beispiele variieren, Kriterien operationalisieren und adaptive Aufgaben vorschlagen; dafür braucht es Leitplanken zu Transparenz, Korrektheit, Fairness, Datenschutz und Barrierefreiheit sowie ein kompetenzbasiertes Zugangsmodell ('''Vertrauensstufen''').<ref>Carless, D.; Boud, D. (2018): The development of student feedback literacy. ''Assessment & Evaluation in Higher Education'', 43(8), 1315–1325.</ref><ref>Deci, E. L.; Ryan, R. M. (2000): The “What” and “Why” of Goal Pursuits. ''Psychological Inquiry'', 11(4), 227–268.</ref><ref>Sweller, J. (1988): Cognitive load during problem solving. ''Cognitive Science'', 12(2), 257–285.</ref> | KI wird in diesem Rahmen als '''Verstärker''' genutzt, nicht als Ersatz pädagogischer Professionalität. Sie kann Fehlermuster identifizieren, Beispiele variieren, Kriterien operationalisieren und adaptive Aufgaben vorschlagen; dafür braucht es Leitplanken zu Transparenz, Korrektheit, Fairness, Datenschutz und Barrierefreiheit sowie ein kompetenzbasiertes Zugangsmodell ('''Vertrauensstufen''').<ref>Carless, D.; Boud, D. (2018): The development of student feedback literacy. ''Assessment & Evaluation in Higher Education'', 43(8), 1315–1325.</ref><ref>Deci, E. L.; Ryan, R. M. (2000): The “What” and “Why” of Goal Pursuits. ''Psychological Inquiry'', 11(4), 227–268.</ref><ref>Sweller, J. (1988): Cognitive load during problem solving. ''Cognitive Science'', 12(2), 257–285.</ref> | ||

[[Datei:FELIX - Feedback mit KI.png|800px|rahmenlos|zentriert]] | |||

''Abbildung: FELIX kann zur Kurzform FIX werden (ohne E und L).'' | |||

Als strukturgebende Lernumgebung dienen '''aiMOOCs''' mit integrierten Interaktionen und Sofort-Rückmeldungen; sie werden über spezialisierte Prompts/GPTs erzeugt, fachlich gerahmt und offen publiziert und unterstützen adaptives Lernen, Mehrfachdifferenzierung und ressourcenschonende Unterrichtsvorbereitung.<ref>Glanz, Udo (2019): [[MOOCs selbst erstellen|MOOCs selbst erstellen – P4P MOOCs in Schule, Ausbildung, Studium]]. Glanz-Verlag.</ref><ref>Glanz, Udo (2025): ''[[KI-Bildungsbuffet]] – aiMOOCs in der Praxis''. Glanz-Verlag.</ref> | Als strukturgebende Lernumgebung dienen '''aiMOOCs''' mit integrierten Interaktionen und Sofort-Rückmeldungen; sie werden über spezialisierte Prompts/GPTs erzeugt, fachlich gerahmt und offen publiziert und unterstützen adaptives Lernen, Mehrfachdifferenzierung und ressourcenschonende Unterrichtsvorbereitung.<ref>Glanz, Udo (2019): [[MOOCs selbst erstellen|MOOCs selbst erstellen – P4P MOOCs in Schule, Ausbildung, Studium]]. Glanz-Verlag.</ref><ref>Glanz, Udo (2025): ''[[KI-Bildungsbuffet]] – aiMOOCs in der Praxis''. Glanz-Verlag.</ref> | ||

| Zeile 23: | Zeile 47: | ||

== Warum Feedback der Motor von Lernen ist == | == Warum Feedback der Motor von Lernen ist == | ||

Feedback ist kein Zusatz, sondern die zentrale Steuergröße wirksamen Unterrichts. Lernende bewegen sich beständig zwischen einem aktuellen Leistungsstand und einem angestrebten Kompetenzziel; Feedback schließt die Lücke, indem es Orientierung gibt, Fehlerbilder sichtbar macht und konkrete nächste Schritte ausweist. Forschung zu formativer Beurteilung zeigt über Fächer und Stufen hinweg, dass nicht die Menge der Rückmeldungen, sondern deren Qualität und Einbettung in Lernhandlungen über den Lernerfolg entscheidet: Wirksam ist Feedback, wenn es zielklar, spezifisch, zeitnah und handlungsleitend ist – und wenn es in eine nachfolgende Überarbeitung mündet.<ref>Black, P.; Wiliam, D. (1998): Assessment and Classroom Learning. ''Assessment in Education'', 5(1), 7–74.</ref><ref>Hattie, J.; Timperley, H. (2007): The Power of Feedback. ''Review of Educational Research'', 77(1), 81–112.</ref><ref>Shute, V. J. (2008): Focus on Formative Feedback. ''Review of Educational Research'', 78(1), 153–189.</ref> Dieses Verständnis rahmt FELIX: Rückmeldung ist kein Ereignis am Ende, sondern ein Zyklus aus Zielklärung, Diagnose und gezielter Weiterarbeit. | |||

== Begriffsklärungen: Feedback, Evaluation, Überarbeitung == | |||

In diesem Buch bezeichnet ''Feedback'' die kriterienbezogene Rückkopplung zwischen einem Lernprodukt oder Lernprozess und einem transparent gemachten Zielzustand. ''Formative'' Rückmeldung begleitet das Lernen, indem sie den Weg zum Ziel strukturiert; ''summative'' Rückmeldung bilanziert Leistungen zu einem Stichtag. Beide Formen können koexistieren, erfüllen aber unterschiedliche Zwecke. Für Lernwachstum ist die formative Funktion entscheidend, denn sie liefert präzise Hinweise, die Lernende unmittelbar in Verbesserungen übersetzen können.<ref>Shute, V. J. (2008): Focus on Formative Feedback. ''Review of Educational Research'', 78(1), 153–189.</ref> ''Evaluation'' wird hier eng gefasst als kriteriengeleitete Einschätzung durch Lernpartner:innen (Peer-Feedback) oder Mentor:innen, mit dem Ziel, Qualität zu erhöhen – nicht, Noten zu vergeben. ''Überarbeitung'' schließlich ist konstitutiver Bestandteil jeder Rückmeldung: Ohne eine sichtbare Revision bleibt Feedback pädagogisch folgenlos. FELIX macht diese drei Elemente explizit und verteilt sie auf Rollen und Stufen, sodass aus punktuellen Rückmeldungen eine verlässliche Kultur entsteht. | |||

== Theoretische Fundamente und Implikationen == | == Theoretische Fundamente und Implikationen == | ||

Lernen ist in weiten Teilen sozial eingebettet. Sozial-konstruktivistische Perspektiven betonen, dass Bedeutung in Interaktionen entsteht; Rückmeldungen sind deshalb als nachvollziehbarer Dialog über Kriterien zu gestalten, in dem Beispiele, Gegenbeispiele und Belege eine zentrale Rolle spielen.<ref>Black, P.; Wiliam, D. (1998): Assessment and Classroom Learning. ''Assessment in Education'', 5(1), 7–74.</ref> Wygotskys ''Zone der nächsten Entwicklung'' unterstreicht, dass Fortschritt dort besonders gut gelingt, wo Lernende knapp jenseits ihres aktuellen Kompetenzniveaus arbeiten und stützende Hilfen (Scaffolds) erhalten – sei es durch Peers, Mentor:innen, KI-Impulse oder Lehrkraft.<ref>Vygotsky, L. S. (1978): ''Mind in Society''. Harvard University Press.</ref> Die Selbstbestimmungstheorie erklärt die motivationalen Bedingungen wirksamen Feedbacks: Autonomie (Wahlmöglichkeiten und Verantwortung), Kompetenz (sichtbare Fortschritte) und soziale Eingebundenheit (wertschätzende Beziehung) müssen adressiert werden, damit Rückmeldungen nicht als Kontrolle, sondern als Unterstützung erlebt werden.<ref>Deci, E. L.; Ryan, R. M. (2000): The “What” and “Why” of Goal Pursuits. ''Psychological Inquiry'', 11(4), 227–268.</ref> Modelle selbstregulierten Lernens zeigen, dass Lernende Strategien zum Planen, Überwachen und Anpassen ihres Handelns benötigen; gut gestaltete Rückmeldungen initiieren genau diese metakognitiven Prozesse und werden in Lernjournalen dokumentiert.<ref>Zimmerman, B. J. (2002): Becoming a Self-Regulated Learner. ''Theory Into Practice'', 41(2), 64–70.</ref> Schließlich begrenzt die kognitive Belastbarkeit, wie viel Information sinnvoll verarbeitet werden kann: Wenige priorisierte Hinweise, die an Kriterien andocken und in eine konkrete Aktion münden, sind lernwirksamer als breite, unsortierte Kommentierungen.<ref>Sweller, J. (1988): Cognitive load during problem solving. ''Cognitive Science'', 12(2), 257–285.</ref> Die Feedback-Interventionstheorie ergänzt: Rückmeldungen, die Aufmerksamkeit von der Aufgabe weg auf die Person lenken, können Leistung mindern; kriterienfokussierte, aufgabennahe Impulse sind überlegen.<ref>Kluger, A. N.; DeNisi, A. (1996): The effects of feedback interventions on performance. ''Psychological Bulletin'', 119(2), 254–284.</ref> | |||

Lernen ist | |||

== Designprinzipien wirksamer Rückmeldung == | == Designprinzipien wirksamer Rückmeldung == | ||

Aus diesen Fundierungen ergeben sich klare Gestaltungsprinzipien für Unterricht und Materialentwicklung. Erstens verlangt wirksames Feedback eine transparente Ziel- und Kriterienarbeit: Lernende müssen wissen, woran Qualität erkennbar ist; Beispiele und Gegenbeispiele helfen, Kriterien zu operationalisieren. Zweitens sollten Hinweise sich auf beobachtbare Merkmale beziehen, nicht auf Intuitionen – etwa auf Textstruktur, Argumentationsqualität, Belegführung, Rechenwege oder Messprotokolle. Drittens gilt das Prioritätsprinzip: Ein einziger nächster Schritt ist oft produktiver als fünf gleichzeitige Forderungen. Viertens ist Zeitnähe zentral: Je kürzer die Lücke zwischen Handlung und Rückmeldung, desto höher die Umsetzungswahrscheinlichkeit. Fünftens schließt jeder Zyklus mit einer sichtbaren Überarbeitung und einem kurzen Reflexionsimpuls (Was wurde geändert? Warum? Welche Evidenz stützt die Änderung?). Eine kompakte Heuristik lautet: {{o}} Ziel und Kriterium benennen {{o}} beobachtbare Evidenz anführen {{o}} genau einen nächsten Schritt priorisieren {{o}} Änderung dokumentieren. Diese Logik entspricht dem Dreischritt ''Feed Up – Feed Back – Feed Forward'' und wird in Übersichtsarbeiten zu formativer Beurteilung breit gestützt.<ref>Hattie, J.; Timperley, H. (2007): The Power of Feedback. ''Review of Educational Research'', 77(1), 81–112.</ref><ref>Shute, V. J. (2008): Focus on Formative Feedback. ''Review of Educational Research'', 78(1), 153–189.</ref> | |||

== Aufgabenqualität als Dreh- und Angelpunkt == | == Aufgabenqualität als Dreh- und Angelpunkt == | ||

Aufgaben sind der Motor jeder Feedbackkultur. Sie definieren den Erkenntnisraum, in dem Kriterien bedeutsam werden, und erzeugen die natürlichen „Ankerpunkte“ für Rückmeldungen. Gute Aufgaben erzwingen Denken statt bloßer Reproduktion, lassen verschiedene Lösungswege zu und enthalten eingebettete Checkpunkte, an denen Zwischenstände sinnvoll überprüft werden können. Eine robuste Progression besteht aus drei Phasen: In der Verstehensphase werden Konzepte geklärt und diagnostische Kurzaufgaben genutzt, um Fehlvorstellungen sichtbar zu machen; in der Anwendungsphase wird mit Kriterien gearbeitet, die Qualität von Produkten oder Problemlösungen messbar machen; in der Transferphase wird das Gelernte auf neue Kontexte übertragen. Digitale aiMOOCs erleichtern diese Architektur, indem sie Sofort-Rückmeldungen für formale und grundlegende Aspekte bereitstellen (z. B. Format, Struktur, Basiskorrektheit), während anspruchsvollere Qualitätsmerkmale (z. B. Argumentationslogik, empirische Angemessenheit, Modellgüte) über Peer-Dialoge, Mentoring, KI-Impulse und Lehrkraft-Feedback adressiert werden.<ref>Glanz, Udo (2019): [[MOOCs selbst erstellen|MOOCs selbst erstellen – P4P MOOCs in Schule, Ausbildung, Studium]]. Glanz-Verlag.</ref><ref>Glanz, Udo (2025): ''[[KI-Bildungsbuffet]] – aiMOOCs in der Praxis''. Glanz-Verlag.</ref> Aus Sicht der kognitiven Belastung bewähren sich dabei kleinschrittige Aufgabenketten, Beispiel–Gegenbeispiel-Paare und fokussierte Kriterienraster, die extrinsische Belastung reduzieren und die aufgabenrelevante Verarbeitung stärken.<ref>Sweller, J. (1988): Cognitive load during problem solving. ''Cognitive Science'', 12(2), 257–285.</ref> | |||

== Prozessarchitektur eines lernwirksamen Zyklus == | == Prozessarchitektur eines lernwirksamen Zyklus == | ||

Ein zielführender Feedbackzyklus in FELIX beginnt mit einer kurzen Ziel- und Kriterienklärung, die nicht nur verbal, sondern mit Artefakten (Beispiel, Gegenbeispiel, Kurzrubrik) abgesichert wird. Es folgt ein Erstentwurf oder eine Erstlösung; eingebettete Systemhinweise (z. B. im aiMOOC) prüfen formale Mindeststandards. Darauf baut eine dialogische Sequenz auf: ein kurzer, kriteriengeleiteter Peer-Austausch mit einer priorisierten Empfehlung; bei Bedarf ein 10–15-minütiges Mentoring-Fenster für strukturierende Unterstützung; anschließend ein KI-Impuls zu genau einem fokussierten Aspekt (z. B. Klarheit von Definitionen, Kohärenz eines Beweisschrittes, Angemessenheit einer Datenvisualisierung); schließlich das Meta-Feedback der Lehrkraft, das gewichtet, priorisiert und auf Transferchancen hinlenkt. Jede Rückmeldestufe endet mit einer konkret geplanten Änderung, die im Lernjournal dokumentiert wird (Ziel – Hinweis – Aktion – Evidenz – Reflexion). Diese Architektur verbindet hohe Frequenz mit kognitiver Steuerbarkeit und macht Fortschritt sichtbar.<ref>Zimmerman, B. J. (2002): Becoming a Self-Regulated Learner. ''Theory Into Practice'', 41(2), 64–70.</ref><ref>Hattie, J.; Timperley, H. (2007): The Power of Feedback. ''Review of Educational Research'', 77(1), 81–112.</ref> | |||

Ein | |||

== Rollen und geteilte Verantwortung in FELIX/FIX == | == Rollen und geteilte Verantwortung in FELIX/FIX == | ||

FELIX verteilt Verantwortung auf fünf Rollen, die sich ergänzen und gegenseitig absichern. Lernende sind aktive Akteure: Sie bringen Ziele, Zwischenstände und Belege ein, entscheiden mit, welchen Hinweis sie zuerst umsetzen, und dokumentieren ihre Änderungen. Peers steigern die Dichte und Vielfalt von Rückmeldungen; richtig angeleitet, erhöhen sie die Kriteriensensibilität der ganzen Lerngruppe und professionalisieren die Sprache des Feedbacks.<ref>Carless, D.; Boud, D. (2018): The development of student feedback literacy. ''Assessment & Evaluation in Higher Education'', 43(8), 1315–1325.</ref><ref>Topping, K. J. (1998): Peer assessment between students in colleges and universities. ''Review of Educational Research'', 68(3), 249–276.</ref> Mentor:innen bieten über das Peer-Niveau hinaus strukturierende Kurzinterventionen in der ZPD; sie helfen, Denkwege zu ordnen, ohne Lösungen vorzugeben.<ref>Vygotsky, L. S. (1978): ''Mind in Society''. Harvard University Press.</ref> KI-Assistenten liefern hochfrequente, kriteriennahe Impulse, generieren Beispiele, prüfen Formate und schlagen nächste Schritte vor – stets gekennzeichnet, fachlich geprüft und in didaktische Routinen eingebettet.<ref>Shute, V. J. (2008): Focus on Formative Feedback. ''Review of Educational Research'', 78(1), 153–189.</ref> Die Lehrkraft fungiert als Xpert: Sie priorisiert, gewichtet und rahmt, sorgt für Anschluss an Standards, Fairness, Datenschutz und Barrierefreiheit und behält den langfristigen Kompetenzaufbau im Blick.<ref>Hattie, J.; Timperley, H. (2007): The Power of Feedback. ''Review of Educational Research'', 77(1), 81–112.</ref> | |||

Rollen | |||

== KI als Verstärker: Potenziale, Grenzen und Leitplanken == | == KI als Verstärker: Potenziale, Grenzen und Leitplanken == | ||

KI kann diagnostische Präzision und Rückmeldefrequenz deutlich erhöhen. Sie erkennt Muster in Texten, Rechnungen oder Messdaten, generiert Vergleichsbeispiele und operationalisiert Kriterien, etwa indem sie typische Fehlerschritte markiert und Alternativen aufzeigt. Doch gerade weil KI leistungsfähig ist, braucht sie pädagogische Leitplanken: Transparenz über ihren Einsatz (Kennzeichnung, Quellenlage), fachliche Prüfung kritischer Hinweise, Datensparsamkeit und klare Speicherfristen, Bias-Achtsamkeit (z. B. Diversitätschecks bei Beispielen) sowie barrierearme Formate. Ein kompetenzbasiertes Zugangsmodell – ''Vertrauensstufen'' – stellt sicher, dass Lernende Funktionen schrittweise freischalten, wenn sie zeigen, dass sie Feedback verantwortungsvoll nutzen (z. B. nach bestandenem Tablet- und KI-Führerschein).<ref>Glanz, Udo (2024): ''[[Vertrauensstufen|Vertrauensstufen mit KI-Einsatz in der Bildung]]''. Glanz-Verlag.</ref> So wird KI zum Verstärker einer bereits tragfähigen Feedbackkultur – nicht zu deren Ersatz. | |||

KI kann | |||

== Häufige Missverständnisse und Gegenstrategien == | == Häufige Missverständnisse und Gegenstrategien == | ||

Drei verbreitete Missverständnisse behindern wirksame Rückmeldungen. Erstens: ''Mehr ist besser.'' Empirisch belastbar ist das Gegenteil – wenige, priorisierte Hinweise mit hohem Umsetzungsgrad schlagen umfangreiche Kommentarlisten.<ref>Shute, V. J. (2008): Focus on Formative Feedback. ''Review of Educational Research'', 78(1), 153–189.</ref> Zweitens: ''Lob genügt.'' Wertschätzung ist wichtig, ersetzt aber keine kriteriengeleitete Anleitung zur Verbesserung. Drittens: ''Die KI macht es schon.'' Ohne didaktische Rahmung, Kriterienklarheit und eine verbindliche Überarbeitungsphase produziert selbst gute KI-Rückmeldung kaum Lerngewinn. Gegenstrategien sind transparente Kriterienarbeit, kurze, planbare Schleifen, explizite Überarbeitungsaufträge, Lernjournale sowie eine systematische Schulung in Feedback-Literacy, damit Lernende Rückmeldungen verstehen, bewerten und in Handlungen überführen können.<ref>Carless, D.; Boud, D. (2018): The development of student feedback literacy. ''Assessment & Evaluation in Higher Education'', 43(8), 1315–1325.</ref> | |||

== Übergang zu Teil II == | |||

Die in Teil I entwickelten Prinzipien bilden das Fundament für das Modell FELIX. In Teil II werden die fünf Stufen – Free Learning, Evaluation, Learning Mentor, Interactive Feedback und Xpert – im Detail entfaltet. Jede Stufe erhält klare Ziele, typische Inputs und Outputs, Qualitätskriterien, wiederkehrende Routinen sowie konkrete Gegenmittel gegen häufige Fehlsteuerungen. Zugleich wird die Kurzform FIX erläutert, die – wo Ressourcen fehlen oder Passung nicht gegeben ist – die Logik von Ziel – Diagnose – nächster Schritt mit drei Stufen aufrechterhält. | |||

<br> | |||

<br> | |||

---- | |||

<br> | |||

<br> | |||

= Teil II: Das Modell FELIX im Detail = | = Teil II: Das Modell FELIX im Detail = | ||

== F – '''Free Learning''' (aiMOOCs mit Sofort-Feedback) == | == F – '''Free Learning''' (aiMOOCs mit Sofort-Feedback) == | ||

'''Ziel und didaktische Logik.''' Free Learning ist das Eingangstor der FELIX-Architektur. Lernende arbeiten selbstgesteuert in strukturierten, offen zugänglichen Lernkursen (aiMOOCs), die Inhalte, Aktivitäten und unmittelbar wirksame Mikrorückmeldungen verbinden. Die Stufe F schafft einen verlässlichen Grundtakt: Vor jeder sozialen oder professionellen Rückmeldung wird Basisqualität hergestellt (Form, Struktur, elementare Richtigkeit). Dadurch werden spätere Feedbackressourcen (Peers, Mentor:innen, Lehrkraft) entlastet und können sich auf höherwertige Qualitätsmerkmale konzentrieren – Argumentationslogik, Problemstrategien, Modellgüte. Diese Vorstrukturierung entspricht der Einsicht, dass kurze, häufige und kriteriennahe Rückmeldeschleifen die lernwirksamsten sind.<ref>Hattie, J.; Timperley, H. (2007): The Power of Feedback. ''Review of Educational Research'', 77(1), 81–112.</ref><ref>Shute, V. J. (2008): Focus on Formative Feedback. ''Review of Educational Research'', 78(1), 153–189.</ref> | |||

'''Struktur und Ablauf.''' Ein aiMOOC beginnt mit einer expliziten Ziel- und Kriterienklärung, illustriert durch Beispiel und Gegenbeispiel. Es folgt eine Folge kleiner Aufgaben, die jeweils einen eingebetteten Check enthalten (z. B. Formatprüfung, Strukturhinweis, grundlegende Richtigkeitskontrolle). Lernende erhalten sofortige, knappe Mikrohints, setzen eine Mini-Revision um und dokumentieren diese im Lernjournal (Ziel – Hinweis – Aktion – Evidenz). Auf diese Weise entstehen beobachtbare Spuren des Lernens, die in den Folgestufen (E, L, I, X) aufgegriffen und verdichtet werden. Die aiMOOC-Umgebung eignet sich dafür, weil sie Interaktion, offene Publikation und differenzierbare Pfade verbindet.<ref>Glanz, Udo (2019): [[MOOCs selbst erstellen|MOOCs selbst erstellen – P4P MOOCs in Schule, Ausbildung, Studium]]. Glanz-Verlag.</ref><ref>Glanz, Udo (2025): ''[[KI-Bildungsbuffet]] – aiMOOCs in der Praxis''. Glanz-Verlag.</ref> | |||

''' | '''Qualitätskriterien und Heuristiken.''' Wirksam ist F, wenn Kriterien sichtbar und operationalisiert sind, Aufgabenprogression kleinschrittig verläuft und Mikrohints strikt auf ein Merkmal zielen. Eine kompakte Heuristik lautet: {{o}} Kriterium zuerst sichtbar machen {{o}} maximal zwei Mikrohints pro Aufgabe {{o}} genau ein nächster Schritt {{o}} Mini-Revision mit Evidenz. Diese Fokussierung schont Arbeitsgedächtnisressourcen und erhöht die Wahrscheinlichkeit, dass Hinweise umgesetzt werden.<ref>Sweller, J. (1988): Cognitive load during problem solving. ''Cognitive Science'', 12(2), 257–285.</ref> | ||

''' | '''Häufige Fehlsteuerungen und Gegenmittel.''' Typische Probleme sind überfrachtete Aufgaben, unklare Kriterien oder zu lange Hints. Gegenmittel sind eine klare Kriterienkarte am Aufgabenbeginn, Beispiel–Gegenbeispiel-Paare, strikte Längenbegrenzung für Hints und verpflichtende Mini-Revisionen. F dient nicht der Vollkorrektur, sondern der Basisstabilisierung; alles Weitere folgt in E, L, I, X. | ||

''' | '''Dokumentation und Anschluss.''' Jede Aufgabe erzeugt eine kurze Spur im Lernjournal. Diese Dokumentation erlaubt späteren Rollen (Peers, Mentor:innen, Lehrkraft), gezielt dort einzusetzen, wo der Lernprozess stockt, und verhindert redundante Rückmeldungen. | ||

---- | |||

== E – '''Evaluation''' (Peer-Feedback) == | == E – '''Evaluation''' (Peer-Feedback) == | ||

'''Ziel und didaktische Logik.''' Evaluation ist kriteriengeleitetes Peer-Feedback als strukturierte, soziale Qualitätsprüfung. Sie erweitert Perspektiven, trainiert Feedback-Literacy und verankert die Sprache der Kriterien im Klassenraum. Dabei ersetzt sie keine Bewertung, sondern liefert handlungsleitende Entwicklungshinweise. Das dialogische Moment ist zentral: In der ko-konstruktiven Auseinandersetzung über Belege und Qualitätsmerkmale verdichten Lernende ihr Verständnis von „guter Arbeit“. Forschung zeigt, dass Peers – gut angeleitet – sowohl Leistung als auch Metakognition positiv beeinflussen können.<ref>Topping, K. J. (1998): Peer assessment between students in colleges and universities. ''Review of Educational Research'', 68(3), 249–276.</ref><ref>Carless, D.; Boud, D. (2018): The development of student feedback literacy. ''Assessment & Evaluation in Higher Education'', 43(8), 1315–1325.</ref> | |||

'''Struktur und Ablauf.''' Nach F bringt jedes Team ein Zwischenprodukt mit klar benannter Ziel-Kriterium-Kombination ein. Peers prüfen an genau diesem Fokus, benennen eine evidenzbasierte Stärke und einen priorisierten nächsten Schritt, der in der verfügbaren Zeit realistisch ist. Der Austausch ist zeitlich knapp gehalten und folgt Satzstartern („Ich sehe Kriterium X belegt in …; ein nächster Schritt wäre …, weil …“). Anschließend setzen Lernende einen einzigen Verbesserungsschritt um und dokumentieren ihn. | |||

''' | '''Qualitätskriterien und Heuristiken.''' Qualität entsteht über Fokussierung, Sprachstützen und Evidenzpflicht. Eine verdichtete Heuristik lautet: {{o}} ein Kriterium {{o}} ein Beleg {{o}} ein nächster Schritt {{o}} sofortige Umsetzung. Diese Regel verhindert „Gefälligkeitsfeedback“ und vage Allgemeinplätze und lenkt Aufmerksamkeit auf das, was den größten Lerngewinn verspricht. | ||

''' | '''Häufige Fehlsteuerungen und Gegenmittel.''' Gefahren sind Personenbezug, ausufernde Diskussionen und Multi-Topic-Feedback. Gegenmittel: Kriterienstarter, zeitliche Taktung (z. B. 2 + 2 + 1 Minuten für Beleg – Schritt – Vereinbarung), Peer-Checklisten mit Minimalanforderungen (Belegpflicht) und die explizite Trennung von Würdigung und Diagnose. | ||

'''Dokumentation und Anschluss.''' Die Peer-Feedback-Karte (Kriterium, Evidenz, nächster Schritt) wird dem Lernjournal beigefügt. Sie ist Ausgangspunkt für L oder I und ermöglicht der Lehrkraft in X, Prioritäten transparent nachzuvollziehen. | |||

---- | |||

== L – '''Learning Mentor''' (gezielte Expertenstütze) == | == L – '''Learning Mentor''' (gezielte Expertenstütze) == | ||

'''Ziel und didaktische Logik.''' Learning Mentors sind thematisch versierte Lernende oder geschulte Schüler-Expert:innen, die über das Peer-Niveau hinaus kurzzeitige Strukturhilfe bieten. Sie wirken als „Brücke“ in der Zone der nächsten Entwicklung: Wenn Peers an Grenzen stoßen (z. B. bei komplexer Argumentation oder Modellierung), strukturieren Mentor:innen Denkwege, ohne Lösungen vorzugeben. Das Prinzip „Lernen durch Lehren“ steigert zugleich das Verständnis der Mentor:innen selbst.<ref>Vygotsky, L. S. (1978): ''Mind in Society''. Harvard University Press.</ref><ref>Glanz, Udo (2024): ''[[KI-Medienmentoren]] – Eine Einführung in Medienbildung mit KI''. Glanz-Verlag.</ref> | |||

'''Struktur und Ablauf.''' Mentoring erfolgt in klar begrenzten 10–15-Minuten-Slots. Vor Beginn formuliert die Ratsuchende Person einen fokussierten Bedarf (z. B. „Kriterium: Kohärenz der Argumentation; Problem: Sprung zwischen Beleg A und Schluss B“). Die Mentor:in liefert maximal zwei Interventionen: eine Strukturierung (z. B. Argument-Template) und eine Leitfrage. Nach der Sitzung wird eine einzige Änderung vereinbart und nach kurzer Zeit kontrolliert (Follow-up). | |||

'''Qualitätskriterien und Heuristiken.''' Wirksam ist L, wenn es fokussiert, zeitlich knapp und evidenzorientiert bleibt. Eine Heuristik – ohne Zeilenumbruch – lautet: {{o}} Bedarf präzisieren {{o}} zwei Interventionen maximal {{o}} eine Änderung vereinbaren {{o}} Follow-up terminieren. So wird verhindert, dass Mentoring in umfangreiche Nachhilfe ausufert. | |||

'''Häufige Fehlsteuerungen und Gegenmittel.''' Risiken sind Überbetreuung (Reduktion der Eigenaktivität), Lösungsvorwegnahme oder Rollenvermischung mit der Lehrkraft. Gegenmittel: Rollenklarheit (Scaffolding statt Korrektorat), Protokollpflicht (Problem – Intervention – Wirkung – Follow-up) und zyklische Rotation der Mentor:innen zur Fairness. | |||

''' | '''Dokumentation und Anschluss.''' Das Mentoring-Protokoll wird dem Lernjournal beigefügt; es zeigt, welche Strukturhilfe gegeben wurde und welche Wirkung erwartet wird. Diese Transparenz erleichtert den Übergang zu I und X. | ||

---- | |||

== I – '''Interactive Feedback''' (KI-gestützte Impulse) == | == I – '''Interactive Feedback''' (KI-gestützte Impulse) == | ||

'''Ziel und didaktische Logik.''' In I liefert KI kriteriennahe, hochfrequente Impulse, ohne Lösungen vorwegzunehmen. Sie diagnostiziert Fehlermuster, erzeugt Gegenbeispiele, prüft Formatkriterien und schlägt nächste Schritte vor. Ihr größter Vorteil liegt in der Taktung: Hinweise erscheinen genau dann, wenn sie gebraucht werden, und können individualisiert werden – stets unter pädagogischer Rahmung und mit klarer Kennzeichnung als KI-Hinweis.<ref>Shute, V. J. (2008): Focus on Formative Feedback. ''Review of Educational Research'', 78(1), 153–189.</ref> | |||

''' | '''Struktur und Ablauf.''' Lernende übergeben der KI einen gezielten Auftrag, der an Kriterien andockt (z. B. „Prüfe Kohärenz meiner Begründung gemäß Kriterium X“). Die KI antwortet in einem festen Format: zwei Stärken, ein priorisierter nächster Schritt, optional eine Leitfrage oder ein Minimal-/Gegenbeispiel. Die Lehrkraft definiert vorher, welche Aspekte automatisiert geprüft werden dürfen und wo menschliche Prüfung zwingend ist. Optional kommen spezialisierte GPTs (z. B. der [https://chatgpt.com/g/g-67330d0027f08190a3fa4bc890763fdf-feedback-schulaufgabe Feedback-Schulaufgabe-GPT]) zum Einsatz; in sensiblen Kontexten sind Offline-Varianten sinnvoll. Vertrauensstufen regeln, welche Funktionen Lernende nutzen dürfen und wann (z. B. nach bestandenem [[Tablet-Führerschein]] und [[KI-Führerschein]]).<ref>Glanz, Udo (2024): ''[[Vertrauensstufen|Vertrauensstufen mit KI-Einsatz in der Bildung]]''. Glanz-Verlag.</ref> | ||

''' | '''Qualitätskriterien und Heuristiken.''' Damit I lernwirksam bleibt, gelten klare Leitplanken: Kennzeichnung aller KI-Hinweise; Bezug auf Kriterien und beobachtbare Evidenz; keine Lösungsvorwegnahme; ein einziger, machbarer nächster Schritt; verpflichtende Mini-Revision. Eine kompakte Prompt-Heuristik – ohne Zeilenumbruch – lautet: {{o}} „Prüfe Kriterium X/Y an meinem Abschnitt Z {{o}} nenne 2 Stärken {{o}} formuliere 1 nächsten Schritt {{o}} stelle 1 Leitfrage – ohne die Lösung zu verraten“. | ||

'''Häufige Fehlsteuerungen und Gegenmittel.''' Risiken sind Überabhängigkeit („KI wird schon richten“), zu breite Hinweise, fehlende Anschlussaktionen oder Datenschutzprobleme. Gegenmittel: Mensch-im-Loop-Prinzip (Lehrkraft priorisiert kritische Punkte), strenge Längenbegrenzung, Pflicht zur Revision mit Nachweis, Datensparsamkeit und klare Speicherregeln. KI ergänzt, ersetzt aber keine professionelle Entscheidung. | |||

'''Dokumentation und Anschluss.''' KI-Hinweise werden im Lernjournal als solche markiert, die umgesetzte Änderung wird kurz begründet. Diese Spur ist Ausgangspunkt für X und verhindert, dass in der Lehrkraft-Konferenz Altes wiederholt wird. | |||

---- | |||

== X – '''Xpert''' (Lehrkraft als letzte Instanz) == | == X – '''Xpert''' (Lehrkraft als letzte Instanz) == | ||

'''Ziel und didaktische Logik.''' X bündelt, gewichtet und rahmt: Die Lehrkraft sichtet die Spuren aus F, E, L und I, priorisiert Hinweise, trifft fachliche Urteile, moderiert Zielanpassungen und empfiehlt nächste Lernschritte. Sie ist Garantin für fachliche Korrektheit, Passung, Fairness, Datenschutz und Barrierefreiheit und verknüpft die aktuelle Aufgabe mit längerfristigen Kompetenzzielen. Die Forschung ordnet diese Meta-Feedback-Rolle zentral ein: Sie entscheidet darüber, ob Rückmeldungen in nachhaltigen Kompetenzaufbau münden.<ref>Hattie, J.; Timperley, H. (2007): The Power of Feedback. ''Review of Educational Research'', 77(1), 81–112.</ref> | |||

'''Struktur und Ablauf.''' Eine 5-Minuten-Lernkonferenz pro Team reicht oft: Kurzdiagnose anhand der Journalspuren, zwei Fokuspunkte (eine Stärke, ein Entwicklungsfeld), eine konkrete Empfehlung (z. B. „Wiederhole Argumentbaustein B und belege ihn, dann wähle Aufgabe T zur Transfersicherung“), Verabredung einer Frist. Wenn nötig, ordnet die Lehrkraft die Reihenfolge künftiger Lernpfade und verweist auf Ressourcenkacheln (Beispiele, Rubriken, Kurzhilfen). | |||

''' | '''Qualitätskriterien und Heuristiken.''' X ist wirksam, wenn es knappe, strategische Impulse liefert, die an Ziele und Kriterien andocken, Anschluss an Standards sichern und den Transfer vorbereiten. Eine Heuristik – ohne Zeilenumbruch – lautet: {{o}} Diagnose aus Spuren {{o}} ein strategischer Fokus {{o}} ein Transferauftrag {{o}} klare Frist und Evidenzform. | ||

'''Häufige Fehlsteuerungen und Gegenmittel.''' Gefahren sind Detailversinken, „Überkommentieren“ und Doppelung bereits gegebener Hinweise. Gegenmittel: strikte Orientierung an Journalspuren, Verzicht auf Wiederholung, Fokus auf Strategien statt Kleinstfehler, Transferorientierung (neue Situation, gleiches Kriterium). | |||

'''Dokumentation und Anschluss.''' Das Xpert-Feedback schließt den Zyklus mit einer sichtbaren Entscheidung: Was bleibt, was wird geändert, was wird transferiert? Mit dieser Entscheidung beginnt die nächste Runde – FELIX ist ein Rhythmus, kein einmaliger Akt. | |||

---- | ---- | ||

= | == Hinweis: '''FIX''' als Kurzform == | ||

Die Stufen '''E – Evaluation''' und '''L – Learning Mentor''' sind optional. Fehlen Peer- oder Mentorenstrukturen, können sie übersprungen werden, ohne die Grundlogik zu verlieren: Ziel klären, Stand diagnostizieren, nächsten Schritt umsetzen. Aus FELIX wird '''FIX''' – schneller im Vollzug (umgangssprachlich „fix“) und zugleich reparierend/festigend im Sinne von „to fix“. FIX fokussiert die Pipeline '''F → I → X''': Basisklärung und Sofort-Rückmeldung im aiMOOC, interaktive, kriteriennahe KI-Impulse, abschließendes Meta-Feedback der Lehrkraft. Diese Kurzform ist besonders geeignet bei Zeitdruck, in neuen Setups oder als Brücke, bis Peer- und Mentorenformate aufgebaut sind. Wichtig bleibt die Verbindlichkeit der Revision und die Dokumentation im Lernjournal, damit auch in FIX jeder Hinweis in beobachtbare Veränderung überführt wird. | |||

---- | |||

== Übergang zu Teil III == | |||

Mit FELIX liegt ein vollständiger Ablaufplan vor, der Rollen trennt, Kriterien sichtbar macht und Überarbeitung als Regelfall etabliert. Teil III zeigt, wie Schulen diese Architektur stufenweise einführen, wie Unterrichtsdesigns für verschiedene Fächer aussehen, welche Vorlagen den Alltag erleichtern und wie Qualität über Hospitation, Dokumentationsspuren und kurze Auswertungsroutinen gesichert werden kann. | |||

<br> | |||

<br> | |||

---- | |||

<br> | |||

<br> | |||

<br> | |||

= | = Teil III: Umsetzung in der Schule = | ||

== Leitbild und Zielbild == | |||

Eine wirksame Feedbackkultur entsteht nicht durch Einzelmaßnahmen, sondern durch ein konsistentes Zusammenspiel von Aufgabenqualität, klaren Rollen, kurzen Rückmeldeschleifen, dokumentierter Revision und verlässlicher Schulorganisation. FELIX liefert dafür die Architektur; FIX ist die pragmatische Kurzform, wenn Peer- und Mentorenstrukturen (noch) fehlen. Das schulische Zielbild lautet: Unterricht, in dem Lernziele und Kriterien sichtbar sind, Feedback früh und häufig ansetzt, auf beobachtbaren Belegen beruht, einen priorisierten nächsten Schritt ausweist und in zeitnahe Überarbeitung mündet. Die KI wird als Verstärker in diese Routinen eingebettet, abgesichert durch Transparenz, Datensparsamkeit, Barrierefreiheit und kompetenzbasierte Zugänge (Vertrauensstufen).<ref>Hattie, J.; Timperley, H. (2007)</ref><ref>Shute, V. J. (2008)</ref><ref>Glanz, U. (2024): ''[[Vertrauensstufen|Vertrauensstufen mit KI-Einsatz in der Bildung]]''</ref> | |||

---- | == Governance und Rollen == | ||

Schulen benötigen eine leichtgewichtige, aber klare Governance: | |||

; Steuergruppe | |||

: Schulleitung, eine Lehrkraft je Fachbereich, IT/Datenschutz, eine Schüler- und eine Elternvertretung. Auftrag: Ziele priorisieren, Meilensteine setzen, Leitplanken beschließen, Evaluation sichern. | |||

; Fachgruppen | |||

: Aufgabenqualität, Kriterienraster, Beispiel-/Gegenbeispielsammlungen, aiMOOC-Kurationslisten, fachspezifische Prompt-Bausteine. | |||

; IT & Datenschutz | |||

: Infrastruktur (lokal/online), Rechte- und Rollensystem, Datensparsamkeit, Speicherfristen, Notfall- und Supportprozesse. | |||

; Fortbildung | |||

: Micro-Module für Feedback-Literacy, KI-Leitplanken, Unterrichtsdesign und Hospitationskultur; Peer-Coaching. | |||

; Lernende | |||

: Lernjournal führen, Rückmeldungen umsetzen, Belege sichern, Vertrauensstufen erwerben (Tablet-/KI-Führerschein). | |||

= | == 90-Tage-Roadmap (Pilot bis Verankerung) == | ||

{| class="wikitable" | |||

! Phase !! Zeitraum !! Fokus !! Ergebnisse | |||

|- | |||

| 0. Vorbereitung || Woche −2 bis 0 || Leitbild schärfen, Steuergruppe einsetzen, Datenschutz klären, zwei Fächer wählen || Beschlusspapier, DPIA-Check, Auswahl Pilotklassen | |||

|- | |||

| 1. Pilot || Wochen 1–4 || Zwei Sequenzen à 2–3 Unterrichtsstunden pro Fach mit FELIX/FIX (aiMOOC, Peer-Karte, KI-Impuls, Xpert-Konferenz) || Erste Artefakte, funktionierende Lernjournale, Kurzfeedback der Beteiligten | |||

|- | |||

| 2. Ausweitung || Wochen 5–8 || Drittes Fach; Mentorenprogramm minimal starten; Vorlagen konsolidieren || Mentorenslots (10–15 Min), Vorlagenpaket v1 | |||

|- | |||

| 3. Verankerung || Wochen 9–12 || Curriculare Verortung, Hospitationszirkel, Elternkommunikation, Fortbildungsmodul „Feedback-Literacy“ || Schulweite Mindeststandards, Terminplan Hospitation, Info-Kit für Eltern | |||

|} | |||

== | == Unterrichtsdesign-Blueprints (45/90 Minuten) == | ||

; 45-Minuten-Takt (z. B. Deutsch) | |||

: Einstieg 5′ Ziel/Kriterium mit Beispiel; aiMOOC-Aufgabe 15′ mit Mikrohints und Mini-Revision; Peer-Feedback 10′ (1 Kriterium, 1 Beleg, 1 Schritt); KI-Impuls 8′ (zwei Stärken, ein Schritt, Leitfrage); Xpert-Hinweis 5′; Journal-Eintrag 2′. | |||

; 90-Minuten-Takt (z. B. Mathematik/NaWi) | |||

: Diagnose 10′; aiMOOC-Pfad 20′; Peer-Runde 15′; Mentoring-Slots 2×12′ parallel; KI-Impuls 10′; Xpert-Konferenz 10′; Transferaufgabe 10′; Journal 3′. | |||

== aiMOOC-Produktion und Kuration == | |||

Ein aiMOOC bündelt Ziel, Kriterien, Aufgabenprogression, Beispiele und Mikrohints. | |||

; Produktions-Workflow | |||

: Lernziel/Kriterium formulieren → Beispiel/Gegenbeispiel erstellen → Aufgaben in 3 Niveaustufen mit eingebetteten Checks → Mikrohints definieren (max. 2 je Aufgabe) → Journal-Prompts einbauen → Veröffentlichung auf [[MOOCit.de]]/[[aiMOOC.org]]. | |||

; Qualitätscheck (Kompaktheuristik) | |||

: {{o}} Kriterium zuerst {{o}} ein Beleg pro Beispiel {{o}} zwei Mikrohints maximal {{o}} ein nächster Schritt {{o}} Journal-Slot vorhanden. | |||

; Kuration | |||

: Fachgruppe pflegt eine Liste geprüfter aiMOOCs (Thema, Stufe, Kriterienbezug, Dauer, Barrierefreiheitsstatus). | |||

== | == Vertrauensstufen und Führerscheine == | ||

Die Nutzung leistungsfähiger KI-Funktionen erfolgt stufenweise. Nachweis erfolgt über kurze, praktische Prüfungen. | |||

{| class="wikitable" | |||

! Stufe !! Freigaben (Beispiele) !! Nachweis | |||

|- | |||

| 0 Basis || Lesen/Nutzen von aiMOOCs, Mikrohints, Journalführung || Tablet-Führerschein: sichere Bedienung, Urheberrecht, Datenminimierung | |||

|- | |||

| 1 KI-Light || Formale Checks (Gliederung, Quellenformate), neutrale Hinweise ohne Lösungen || KI-Führerschein Teil A: „Kennzeichne KI-Hinweise, belege Umsetzungen“ | |||

|- | |||

| 2 KI-Fokus || Kriteriennahe Impulse (2 Stärken, 1 Schritt, 1 Leitfrage), Minimal-/Gegenbeispiele || KI-Führerschein Teil B: „Arbeite 3 Hinweise in Revisionen ein“ | |||

|- | |||

| 3 KI-Plus || Vergleichsaufgaben, Transfervorschläge, Selbstcheck-Generator || Portfolio-Nachweis: drei vollständige Zyklen inkl. Transfer | |||

|} | |||

== Datenschutz, Sicherheit, Barrierefreiheit == | |||

; Datenschutz & DPIA | |||

: Datenminimierung (Textauszüge statt Volltexte), Pseudonymisierung, klare Speicherfristen, Protokolltransparenz, lokale Alternativen bei sensiblen Inhalten. | |||

; Sicherheit | |||

: Rollenrechte, Logging, Notfallabläufe (Abschalten einzelner Funktionen), jährlicher Technik-Check. | |||

; Barrierefreiheit | |||

: Alternativformate (Audio, große Schrift), einfache Sprache, Tastaturbedienbarkeit, Farbkodierungen mit ausreichendem Kontrast, Medienarme Alternativen für leistungsschwache Netze. | |||

== | == Fortbildungscurriculum für Kollegium == | ||

; Modul A Feedback-Grundlagen | |||

: Ziel/Kriterium, Feed Up/Back/Forward, Kurzrubriken; Mikro-Design-Sprints. | |||

; Modul B Aufgabenqualität | |||

: Beispiel-Gegenbeispiel, Progression, kognitive Last steuern. | |||

; Modul C Peer & Mentoring | |||

: Satzstarter, Belegpflicht, 10–15-Min-Mentorings, Protokolle. | |||

; Modul D KI in FELIX | |||

: Prompt-Bausteine, Kennzeichnung, Mensch-im-Loop, Vertrauensstufen. | |||

; Modul E Hospitationskultur | |||

: Beobachtungskarten, kollegiale Kurzfeedbacks, Follow-up. | |||

== Micro-Curriculum für Lernende: Feedback-Literacy == | |||

Vier Kurzlektionen à 20–30 Minuten, fächerübergreifend: | |||

; L1 Kriterien sehen lernen | |||

: Beispiel/Gegenbeispiel markieren; „Woran erkennt man Qualität?“ | |||

; L2 Ein Beleg – ein Schritt | |||

: Evidenzformeln („Ich sehe Kriterium X belegt in …“), Priorisierung. | |||

; L3 Journal-Routine | |||

: Ziel – Hinweis – Aktion – Evidenz – Reflexion; zwei Stärken, ein Schritt. | |||

; L4 KI kompetent nutzen | |||

: Kennzeichnung, Datensparsamkeit, strukturiertes Prompten, Revision belegen. | |||

-- | == Kommunikationsplan (Innen/Außen) == | ||

; Kollegium | |||

: Monatsbrief „FELIX-Praxis“ mit Beispielen; Hospitationskalender; FAQ. | |||

; Lernende | |||

: Startbrief „So funktioniert Feedback hier“; Vertragsfolie: „Wir geben wenige, aber präzise Hinweise – du änderst sichtbar und belegst.“ | |||

; Eltern/Öffentlichkeit | |||

: Informationsabend; Einseiter mit Leitprinzipien; Beispielseite aus dem Lernjournal; Datenschutz-Hinweise; Nutzenargumente (Transparenz, Nachvollziehbarkeit, Teilhabe). | |||

= | == Qualitätsindikatoren und Monitoring == | ||

Qualität wird über Spuren, nicht über zusätzliche Tests sichtbar. Minimal-Dashboard pro Klasse: | |||

; Indikatoren | |||

: Anteil Stunden mit transparenter Kriteriennennung; Anteil Produkte mit Journal-Eintrag; mittlere Zeit bis zur Umsetzung eines nächsten Schritts; Verteilung der Feedback-Quellen (F/E/L/I/X); Anzahl dokumentierter Transfers pro Einheit. | |||

; Erhebung | |||

: Stichproben aus Journals (5–8 pro Klasse/Monat), Kurzbefragung 3 Fragen („Wusste ich das Ziel? Was habe ich geändert? Woran sehe ich Fortschritt?“), Hospitationen mit Kurzcheck. | |||

; Auswertung | |||

: Monatliche 30-Min-Runde je Fachgruppe; ein Beschluss – eine Änderung für den kommenden Monat. | |||

== | == Beispiel-Blueprints je Fach == | ||

=== Deutsch (Argumentierendes Schreiben, 2×45 Min) === | |||

Tag 1: Ziel/Kriterium „Behauptung – Begründung – Beleg – Bezug“; aiMOOC-Aufgabenfolge mit Mikrohints; Mini-Revision; Peer-Feedback „1 Kriterium – 1 Beleg – 1 Schritt“; Journal. | |||

Tag 2: Mentoring-Slots zu Kohärenz; KI-Impuls mit Gegenbeispiel; Xpert-Konferenz (5′/Team) mit Transferauftrag „Gleiches Kriterium, neuer Textausschnitt“; Journal-Reflexion. | |||

== | === Mathematik (Quadratische Funktionen, 90 Min) === | ||

Diagnose-Item; aiMOOC-Fehlermuster (Scheitel/Normalform); Peer-Check „Rechenweg belegen“; Mentoring zu Umformungen; KI-Impuls „Vergleich zweier Lösungswege“; Xpert-Fokus auf Strategie; Transfer „Parameter-Variation“. | |||

=== NaWi (Daten und Messfehler, 45 Min) === | |||

Ziel/Kriterium „Plausible Messreihe, Fehlerquellen, Visualisierung“; aiMOOC-Checkliste; Peer-Poster-Review mit Belegpflicht; KI-Hinweis zu Achsen/Skala; Xpert-Auftrag „Gleiche Daten, andere Visualisierung – begründe Wahl“. | |||

== | == Vorlagenpaket (Kernauszüge) == | ||

; Peer-Karte | |||

: Kriterium: ____ | Evidenzstelle: ____ | Ein nächster Schritt: ____ | Umsetzung bis: ____ | umgesetzt? ja/nein | |||

; Mentoring-Protokoll | |||

: Problem: ____ | Intervention 1 (Struktur): ____ | Intervention 2 (Leitfrage): ____ | Vereinbarte Änderung: ____ | Follow-up: ____ | |||

; Xpert-Kurzrubrik (0–3) | |||

: Ziel/Kriterium benannt? 0–3 | Evidenz vorhanden? 0–3 | Nächster Schritt präzise? 0–3 | Revision sichtbar? 0–3 | Transfer geplant? 0–3 | |||

; Prompt-Bausteine I (ohne Zeilenumbruch) | |||

: {{o}} Prüfe Kriterium X an Abschnitt Y; nenne 2 Stärken und 1 nächsten Schritt; stelle 1 Leitfrage – ohne Lösung vorwegzunehmen | |||

== Risiko-Register und Gegenmaßnahmen == | |||

; Überfülle | |||

: Gegenmittel: Max. 1 Schritt; harte Längenbegrenzung; Priorisierungsmatrix. | |||

; Rollenunschärfe | |||

: Gegenmittel: Rollenkarten; Protokollpflicht bei L; Kennzeichnung von I. | |||

; Datenrisiko | |||

: Gegenmittel: Pseudonyme, Offlinemodus, kurze Retention, Opt-out-Pfad. | |||

; Ungleichheit | |||

: Gegenmittel: Differenzierte Zugänge, zusätzliche Zeitfenster, analoge Alternativen. | |||

< | == Ressourcen und Aufwand == | ||

Startaufwand konzentriert sich auf drei Bereiche: Aufgabenqualität (einmalig je Fach zwei Beispiel-Sequenzen mit Kriterienraster), Vorlagen (Peer-Karte, Journal, Mentoring-Protokoll, Xpert-Rubrik) und Fortbildung (4×45-Min-Micro-Module). Laufend sinkt der Korrekturaufwand durch Verlagerung auf Mikrohints, fokussierte Peer-Beiträge und 5-Min-Xpert-Konferenzen; die Lehrkraft investiert stärker in Aufgabendesign und Priorisierung, gewinnt jedoch Zeit durch weniger „Vollkorrekturen“ bei höherer Lernwirksamkeit.<ref>Black, P.; Wiliam, D. (1998)</ref><ref>Hattie, J.; Timperley, H. (2007)</ref> | |||

== | == Gerechtigkeit und Teilhabe == | ||

FELIX/FIX stärkt Teilhabe, wenn drei Bedingungen aktiv verfolgt werden: Barrierearme Aufgabenformate und Alternativen; transparente Kriterien in einfacher Sprache mit Beispielen; dokumentierte Revisionen als sichtbare Fortschrittsspur statt alleiniger Produktbewertung. Diese Bedingungen unterstützen insbesondere Lernende mit Sprachbedarfen, mit geringem Vorwissen oder mit wenig häuslicher Unterstützung – denn sie machen Anforderungen sichtbar und Wege dorthin machbar. | |||

== Abschließender Korridor für die Schulentwicklung == | |||

Nach 90 Tagen Pilotierung ist das Ziel eine schulweite Minimalpraxis: Jede Lernsequenz beginnt mit Ziel/Kriterium und endet mit dokumentierter Revision; jede Klasse nutzt zumindest FIX in eng getakteten Schleifen; Peer- und Mentorenformate wachsen stufenweise; KI-Impulse sind gekennzeichnet, kriteriennah und in Mensch-im-Loop-Routinen eingebettet. Von hier aus skaliert die Schule über Curriculumanpassung, Hospitation und Vorlagenpflege. Damit wird Feedback vom sporadischen Ereignis zur verlässlichen Kultur – transparent, gerecht und lernwirksam. | |||

== | |||

| Zeile 154: | Zeile 318: | ||

<br> | <br> | ||

<br> | <br> | ||

---- | |||

<br> | <br> | ||

<br> | <br> | ||

<br> | <br> | ||

= Teil IV: Varianten, Risiken, Qualitätssicherung = | |||

== Varianten und Anpassungen == | |||

FELIX ist ein architektonisches Modell und daher in unterschiedlichen Kontexten adaptierbar, ohne seine Logik zu verlieren. Fachliche Varianten betreffen vor allem die Art der Kriterien und der natürlichen Rückmeldepunkte. In sprachlichen Fächern rücken Textqualität, Argumentationslogik, Kohärenz und Stil in den Mittelpunkt; Rückmeldungen arbeiten mit markierten Beispiel- und Gegenbeispielpassagen, mit Fokus auf Belegführung und Überarbeitungsschritten im Lauftext. In MINT-Fächern sind Fehlerkategorien, Rechenwege, Modellannahmen, Messprotokolle und Visualisierungen leitend; hier bieten sich strukturierte Fehleranalysen, Minimal- und Gegenbeispiele, sowie kurze Format-Checks (Einheiten, Achsenskalierung) an. In den Künsten und in Projektfächern dominieren Prozessfeedback, Kriterien zu Komposition bzw. Gestaltung, iteratives Prototyping und Transferaufträge, die das Kriterium in einen neuen Ausdruckskontext setzen. Altersvarianten betreffen den Grad der Anleitung: In der Primarstufe sichern Satzstarter, enge Zeitfenster und sichtbare Belegkarten die Dialogqualität; in der Sekundarstufe wachsen Autonomie und fachliche Tiefe, Peer-Dialoge werden stärker kriteriengeleitet, Mentoring kann als Schüler-Expert:innen-Programm institutionalisiert werden.<ref>Black, P.; Wiliam, D. (1998): Assessment and Classroom Learning. ''Assessment in Education'', 5(1), 7–74.</ref><ref>Topping, K. J. (1998): Peer assessment between students in colleges and universities. ''Review of Educational Research'', 68(3), 249–276.</ref> | |||

Organisationsvarianten ergeben sich aus Infrastruktur und Datenschutz. Wo stabile Online-Verbindungen, Single-Sign-on und schulische Cloud-Dienste verfügbar sind, können aiMOOCs, kollaborative Dokumente und KI-Begleiter nahtlos eingebunden werden. Wo dies nicht gegeben ist, bleibt die Logik identisch, die Umsetzung aber medienärmer: aiMOOCs werden als lokales Paket bereitgestellt, Mikrohints erscheinen in gedruckten Checkkarten, Peer- und Mentorenarbeit wird analog protokolliert, KI-Impulse werden in Offlinelösungen oder mit starker Datensparsamkeit genutzt. Entscheidender als das Tool ist die Routine: Ziel/Kriterium sichtbar, kurzer Rückmeldepunkt, ein priorisierter nächster Schritt, dokumentierte Mini-Revision. Diese Sequenz bleibt unabhängig von Fach, Jahrgang und Medienausstattung gültig.<ref>Shute, V. J. (2008): Focus on Formative Feedback. ''Review of Educational Research'', 78(1), 153–189.</ref><ref>Sweller, J. (1988): Cognitive load during problem solving. ''Cognitive Science'', 12(2), 257–285.</ref> | |||

== Risiken und Gegenmaßnahmen == | |||

Mehrere wiederkehrende Risiken lassen sich in Routinen übersetzen. Überabhängigkeit von KI führt zu passiven Lernhaltungen; Gegenmaßnahme ist das Mensch-im-Loop-Prinzip (Lehrkraft priorisiert, validiert und rahmt kritische Punkte) sowie die Verpflichtung zur sichtbaren Revision mit Beleg im Lernjournal. Kognitive Überlastung entsteht durch überlange, unpriorisierte Hinweise; Gegenmaßnahme sind knappe, kriterienfokussierte Impulse und die Heuristik „ein nächster Schritt“ pro Zyklus.<ref>Sweller, J. (1988)</ref> Motivationale Kosten entstehen, wenn Feedback als Kontrolle erlebt wird; die Gegenstrategie ist eine Tonalität, die Autonomie stützt, Kompetenz sichtbar macht und Zugehörigkeit respektiert, sowie Wahlräume bei der Reihenfolge von Schritten.<ref>Deci, E. L.; Ryan, R. M. (2000): The “What” and “Why” of Goal Pursuits. ''Psychological Inquiry'', 11(4), 227–268.</ref> Ungleichheit verstärkt sich, wenn Vorerfahrungen, Sprachkenntnisse oder häusliche Unterstützung stark variieren; Gegenmaßnahmen sind barrierearme Formate, klare Sprache, Alternativwege (Audio, große Schrift, medienarme Varianten), Zusatzzeitfenster und die bewusste Trennung von Würdigung und Diagnose. Datenschutz- und Fairnessrisiken adressiert die Schule über Datensparsamkeit, Pseudonymisierung, klare Speicherfristen, Rollenrechte und ein gestuftes Freigabesystem (Vertrauensstufen) für sensible KI-Funktionen.<ref>Glanz, Udo (2024): ''[[Vertrauensstufen|Vertrauensstufen mit KI-Einsatz in der Bildung]]''. Glanz-Verlag.</ref> | |||

Ein häufiges Missverständnis ist der Glaube, mehr Feedback sei automatisch besser. Die Forschung zeigt, dass Qualität, Zeitpunkt und Einbettung entscheidend sind: Zielklarheit, Bezug zu beobachtbaren Merkmalen, Spezifität, Zeitnähe und Handlungsleitung – und vor allem die anschließende Überarbeitung – bestimmen die Wirkung.<ref>Hattie, J.; Timperley, H. (2007): The Power of Feedback. ''Review of Educational Research'', 77(1), 81–112.</ref><ref>Shute, V. J. (2008)</ref> FELIX operationalisiert genau diese fünf Merkmale in einem wiederkehrenden Rhythmus. | |||

= | == Qualitätssicherung als Routine == | ||

Qualitätssicherung ist bei FELIX kein Sonderprogramm, sondern Teil der Alltagsarchitektur. Drei Bausteine tragen: Hospitationen im Kurzformat, Dokumentationsspuren und kollegiale Auswertungsschleifen. Kurz-Hospitationen mit Beobachtungskarten fokussieren auf sichtbare Ziele/Kriterien, auf den Takt der Rückmeldeschleifen und auf die Evidenz dokumentierter Revisionen. Dokumentationsspuren im Lernjournal – Ziel, Hinweis, Aktion, Evidenz, Reflexion – dienen als minimalinvasive Nachweise, die ohne Zusatzbelastung für Lernende entstehen und für Lehrkräfte, Mentor:innen und Peers anschlussfähig sind. Monatliche Fachgruppenrunden nutzen kleine Stichproben aus Journals und zwei bis drei Artefakte pro Klasse, um einen einzigen Verbesserungsbeschluss zu fassen. Diese Form des Micro-Monitorings macht Fortschritt sichtbar, ohne Unterricht zu überfrachten, und fördert zugleich Feedback-Literacy im Kollegium.<ref>Black, P.; Wiliam, D. (1998)</ref><ref>Carless, D.; Boud, D. (2018): The development of student feedback literacy. ''Assessment & Evaluation in Higher Education'', 43(8), 1315–1325.</ref> | |||

Ein zusätzlicher Baustein ist die Rubrik-Kalibrierung: In kurzen Design-Sprints gleichen Fachgruppen Beispiel- und Gegenbeispielartefakte mit einer Kurzrubrik ab, um die Sprache der Kriterien zu schärfen und Urteilsdrift zu reduzieren. Diese Kalibrierung senkt den späteren Kommentieraufwand, weil die gemeinsame Bezugsbasis robust ist und Rückmeldungen sich an explizit geteilten Qualitätsmerkmalen orientieren.<ref>Hattie, J.; Timperley, H. (2007)</ref> | |||

== | == FIX als Übergangs- und Notfallmodus == | ||

FIX – die Kurzform ohne E und L – ist nicht nur ein „Sparprogramm“, sondern ein geordneter Übergangsmodus, wenn Zeit, Personal oder Strukturen fehlen. In FIX bleiben die Wirkprinzipien erhalten: Basisklärung und Sofort-Rückmeldung (F), ein fokussierter KI-Impuls (I) und die gewichtende, beratungsoffene Lehrkraft (X). Schulen nutzen FIX, um die Logik zu etablieren und Peer- sowie Mentorenformate schrittweise aufzubauen. Wichtig ist die konsequente Journalführung, damit auch im Kurzmodus jede Rückmeldung in eine beobachtbare Veränderung überführt wird. | |||

= | = Teil V: Vorlagen, Glossar, Literatur = | ||

=== | == Vorlagen (ausformulierte Mustertexte) == | ||

'''Peer-Feedback-Karte (ein Kriterium – ein Beleg – ein Schritt).''' | |||

Kriterium (Fokus): [z. B. „Begründung stützt die Behauptung mit überprüfbaren Belegen“]. Evidenz (wo genau im Produkt sehe ich das Kriterium erfüllt oder verfehlt?): [Zitat/Zeilenangabe/Abschnitt]. Ein priorisierter nächster Schritt (konkret, in 10–15 Minuten umsetzbar, ohne Lösung vorwegzunehmen): [z. B. „Ergänze nach Satz 3 einen Beleg aus Quelle A und erkläre in einem Satz den Zusammenhang zur Behauptung“]. Umsetzung bis: [Zeitpunkt]. Journalnotiz: [„Geändert: …; warum: …; Evidenz: …“]. Kompaktregel ohne Zeilenumbruch: {{o}} ein Kriterium {{o}} ein Beleg {{o}} ein Schritt {{o}} sofortige Umsetzung. | |||

'''Mentoring-Protokoll (Problem – Intervention – Wirkung – Follow-up).''' | |||

Problemfokus in der ZPD: [z. B. „Sprung zwischen Beleg und Schlussfolgerung“]. Intervention 1 (Struktur): [Template/Gliederung]. Intervention 2 (Leitfrage): [„Wie führt der Beleg genau zur Schlussfolgerung?“]. Vereinbarte Änderung (eine): [„Beleg-Satz ergänzen und verknüpfenden Satz formulieren“]. Follow-up (Zeitpunkt/Belegform): [„Journal-Eintrag und markierte Änderung“]. Rollenklarheit: Scaffolding statt Lösungsvorwegnahme.<ref>Vygotsky, L. S. (1978): ''Mind in Society''. Harvard University Press.</ref><ref>Glanz, Udo (2024): ''[[KI-Medienmentoren]] – Eine Einführung in Medienbildung mit KI''. Glanz-Verlag.</ref> | |||

'''Xpert-Kurzkonferenz (5 Minuten, meta-orientiert).''' | |||

Diagnose aus Journalspuren: [kurze Zusammenfassung]. Strategischer Fokus: [eine Stärke, ein Entwicklungsfeld]. Empfehlung (ein Transferauftrag, der dasselbe Kriterium in neuem Kontext prüft): [z. B. „Formuliere die Begründung zu Abschnitt B nach demselben Muster“]. Frist und Evidenzform: [„bis …; markierte Änderung im Journal“]. Leitprinzip ohne Zeilenumbruch: {{o}} Diagnose aus Spuren {{o}} ein strategischer Fokus {{o}} ein Transferauftrag {{o}} klare Frist/Evidenz.<ref>Hattie, J.; Timperley, H. (2007)</ref> | |||

'''Lernjournal-Seite (eine Zeile pro Zyklus).''' | |||

Ziel/Kriterium: […]; Hinweis (Quelle F/E/L/I/X): […]; Aktion (konkrete Änderung): […]; Evidenz (wo ist die Änderung sichtbar?): […]; Reflexion (Was habe ich gelernt? Was mache ich als Nächstes?): […]<ref>Zimmerman, B. J. (2002): Becoming a Self-Regulated Learner. ''Theory Into Practice'', 41(2), 64–70.</ref> | |||

'''Prompt-Bausteine für I (KI-Impulse, ohne Lösungsvorwegnahme).''' | |||

Ohne Zeilenumbrüche: {{o}} Prüfe Kriterium X an Abschnitt Y; nenne 2 Stärken und 1 nächsten Schritt; stelle 1 Leitfrage – ohne die Lösung vorwegzunehmen {{o}} Liefere ein Minimal- und ein Gegenbeispiel für das Konzept Z; markiere, welche Eigenschaft das Kriterium erfüllt/verfehlt {{o}} Prüfe die Kohärenz zwischen Beleg A und Schlussfolgerung B; schlage genau 1 Formulierung vor, die die Brücke verstärkt – ohne inhaltlich neu zu argumentieren.<ref>Shute, V. J. (2008)</ref> | |||

== | == Glossar (ausgewählte Kernbegriffe) == | ||

'''Formative Rückmeldung.''' Prozessbegleitende, kriterienorientierte Rückmeldung mit dem Ziel, die nächste Verbesserungshandlung zu ermöglichen; sie ist zielklar, spezifisch, zeitnah und handlungsleitend und mündet in eine sichtbare Überarbeitung.<ref>Shute, V. J. (2008)</ref> | |||

'''Feedback-Literacy.''' Fähigkeit von Lernenden (und Lehrenden), Rückmeldungen zu verstehen, zu bewerten, in Handlungen zu übersetzen und die Wirkung der Handlung zu prüfen; umfasst Kriteriensensibilität, Evidenzorientierung und Priorisierung.<ref>Carless, D.; Boud, D. (2018)</ref> | |||

'''Scaffolding.''' Zeitweilige, strukturierende Unterstützung in der Zone der nächsten Entwicklung; Hilfe wird mit wachsender Kompetenz schrittweise reduziert.<ref>Vygotsky, L. S. (1978)</ref> | |||

'''aiMOOC.''' Offener, KI-gestützter Lernkurs mit integrierten Interaktionen und Sofort-Rückmeldungen, der adaptives Lernen und Mehrfachdifferenzierung ermöglicht und als Basisstufe von FELIX dient.<ref>Glanz, Udo (2019)</ref><ref>Glanz, Udo (2025)</ref> | |||

'''Vertrauensstufen.''' Kompetenzbasiertes Zugangsmodell zu KI-Funktionen; schrittweise Freischaltung je nach nachgewiesener Feedback-Kompetenz und Medienverantwortung (z. B. Tablet-/KI-Führerschein).<ref>Glanz, Udo (2024)</ref> | |||

'''Feed Up / Feed Back / Feed Forward.''' Zielklärung, Standortbestimmung und nächster Schritt als Dreischritt wirksamer Rückmeldung; Kernheuristik der FELIX-Architektur.<ref>Hattie, J.; Timperley, H. (2007)</ref> | |||

'''Kognitive Belastung.''' Begrenzte Arbeitsgedächtniskapazität, die durch priorisierte, kurze, kriteriennahe Hinweise geschont und für lernrelevante Verarbeitung genutzt werden sollte.<ref>Sweller, J. (1988)</ref> | |||

== | == Literatur und weiterführende Quellen == | ||

Die folgenden Werke bilden die theoretische Grundlage des Modells und seiner Umsetzung in aiMOOC-basierten Lernumgebungen, Peer- und Mentorenformaten sowie KI-gestützten Rückmelderoutinen: | |||

<references/> | |||

== | == Schlussbild: FELIX als schulischer Arbeitsrhythmus == | ||

FELIX ist kein einmaliges Projekt, sondern ein schulischer Arbeitsrhythmus: Ziele und Kriterien sichtbar machen; kurze, kriterienfokussierte Rückmeldungen geben; genau einen nächsten Schritt priorisieren; die Änderung zeitnah und sichtbar umsetzen; den Transfer in eine neue Situation planen. Die KI verstärkt diesen Rhythmus, indem sie Diagnosen beschleunigt und Beispiele variiert, ohne pädagogische Entscheidungen zu ersetzen. FIX sichert dieselben Wirkprinzipien unter engen Ressourcen und dient als Brücke, bis Evaluation und Mentoring aufgebaut sind. So wird Feedback vom sporadischen Ereignis zur verlässlichen Kultur – transparent, gerecht und lernwirksam. | |||

== | = VERSION 2= | ||

Aktuelle Version vom 1. Dezember 2025, 08:51 Uhr

FELIX

FELIX – Feedbackkultur mit KI

Vorwort

Dieses Buch entfaltet mit FELIX und der Kurzform FIX eine wissenschaftlich begründete, praxistaugliche Architektur für Feedbackkultur im Zeitalter der Künstlichen Intelligenz (KI). Im Zentrum steht Lernen als sozial eingebetteter, kognitiv anspruchsvoller und zielgerichteter Prozess, der durch geeignete Rückmeldungen sichtbar, steuerbar und nachhaltig wird. Forschung zu formativer Beurteilung und Feedback zeigt konsistent: Rückmeldungen sind dann wirksam, wenn sie früh ansetzen, an expliziten Zielen ausgerichtet sind, sich auf beobachtbare Merkmale beziehen, handlungsleitend formuliert sind und zeitnah in Überarbeitung münden.[1][2][3]

FELIX beschreibt fünf ineinandergreifende Stufen:

- Free Learning (strukturierte Lernumgebungen mit Sofort-Rückmeldung),

- Evaluation (Peer-Feedback),

- Learning Mentor (gezielte Expertenstütze),

- Interactive Feedback (KI-gestützte Impulse) und

- (E)Xpert (reflektierende Lehrkraft).

FIX ist die pragmatische Kurzform ohne E und L, wenn Peer- oder Mentorenstrukturen situativ fehlen. Der Name FELIX verweist etymologisch auf felix = der Glückliche/Erfolgreiche/Fruchtbare und steht sinnbildlich für eine Lernkultur, die Freude, Wirksamkeit und Wachstum ermöglicht.

KI wird in diesem Rahmen als Verstärker genutzt, nicht als Ersatz pädagogischer Professionalität. Sie kann Fehlermuster identifizieren, Beispiele variieren, Kriterien operationalisieren und adaptive Aufgaben vorschlagen; dafür braucht es Leitplanken zu Transparenz, Korrektheit, Fairness, Datenschutz und Barrierefreiheit sowie ein kompetenzbasiertes Zugangsmodell (Vertrauensstufen).[4][5][6]

Abbildung: FELIX kann zur Kurzform FIX werden (ohne E und L).

Als strukturgebende Lernumgebung dienen aiMOOCs mit integrierten Interaktionen und Sofort-Rückmeldungen; sie werden über spezialisierte Prompts/GPTs erzeugt, fachlich gerahmt und offen publiziert und unterstützen adaptives Lernen, Mehrfachdifferenzierung und ressourcenschonende Unterrichtsvorbereitung.[7][8]

Teil I: Grundlagen der Feedbackkultur

Warum Feedback der Motor von Lernen ist

Feedback ist kein Zusatz, sondern die zentrale Steuergröße wirksamen Unterrichts. Lernende bewegen sich beständig zwischen einem aktuellen Leistungsstand und einem angestrebten Kompetenzziel; Feedback schließt die Lücke, indem es Orientierung gibt, Fehlerbilder sichtbar macht und konkrete nächste Schritte ausweist. Forschung zu formativer Beurteilung zeigt über Fächer und Stufen hinweg, dass nicht die Menge der Rückmeldungen, sondern deren Qualität und Einbettung in Lernhandlungen über den Lernerfolg entscheidet: Wirksam ist Feedback, wenn es zielklar, spezifisch, zeitnah und handlungsleitend ist – und wenn es in eine nachfolgende Überarbeitung mündet.[9][10][11] Dieses Verständnis rahmt FELIX: Rückmeldung ist kein Ereignis am Ende, sondern ein Zyklus aus Zielklärung, Diagnose und gezielter Weiterarbeit.

Begriffsklärungen: Feedback, Evaluation, Überarbeitung

In diesem Buch bezeichnet Feedback die kriterienbezogene Rückkopplung zwischen einem Lernprodukt oder Lernprozess und einem transparent gemachten Zielzustand. Formative Rückmeldung begleitet das Lernen, indem sie den Weg zum Ziel strukturiert; summative Rückmeldung bilanziert Leistungen zu einem Stichtag. Beide Formen können koexistieren, erfüllen aber unterschiedliche Zwecke. Für Lernwachstum ist die formative Funktion entscheidend, denn sie liefert präzise Hinweise, die Lernende unmittelbar in Verbesserungen übersetzen können.[12] Evaluation wird hier eng gefasst als kriteriengeleitete Einschätzung durch Lernpartner:innen (Peer-Feedback) oder Mentor:innen, mit dem Ziel, Qualität zu erhöhen – nicht, Noten zu vergeben. Überarbeitung schließlich ist konstitutiver Bestandteil jeder Rückmeldung: Ohne eine sichtbare Revision bleibt Feedback pädagogisch folgenlos. FELIX macht diese drei Elemente explizit und verteilt sie auf Rollen und Stufen, sodass aus punktuellen Rückmeldungen eine verlässliche Kultur entsteht.

Theoretische Fundamente und Implikationen

Lernen ist in weiten Teilen sozial eingebettet. Sozial-konstruktivistische Perspektiven betonen, dass Bedeutung in Interaktionen entsteht; Rückmeldungen sind deshalb als nachvollziehbarer Dialog über Kriterien zu gestalten, in dem Beispiele, Gegenbeispiele und Belege eine zentrale Rolle spielen.[13] Wygotskys Zone der nächsten Entwicklung unterstreicht, dass Fortschritt dort besonders gut gelingt, wo Lernende knapp jenseits ihres aktuellen Kompetenzniveaus arbeiten und stützende Hilfen (Scaffolds) erhalten – sei es durch Peers, Mentor:innen, KI-Impulse oder Lehrkraft.[14] Die Selbstbestimmungstheorie erklärt die motivationalen Bedingungen wirksamen Feedbacks: Autonomie (Wahlmöglichkeiten und Verantwortung), Kompetenz (sichtbare Fortschritte) und soziale Eingebundenheit (wertschätzende Beziehung) müssen adressiert werden, damit Rückmeldungen nicht als Kontrolle, sondern als Unterstützung erlebt werden.[15] Modelle selbstregulierten Lernens zeigen, dass Lernende Strategien zum Planen, Überwachen und Anpassen ihres Handelns benötigen; gut gestaltete Rückmeldungen initiieren genau diese metakognitiven Prozesse und werden in Lernjournalen dokumentiert.[16] Schließlich begrenzt die kognitive Belastbarkeit, wie viel Information sinnvoll verarbeitet werden kann: Wenige priorisierte Hinweise, die an Kriterien andocken und in eine konkrete Aktion münden, sind lernwirksamer als breite, unsortierte Kommentierungen.[17] Die Feedback-Interventionstheorie ergänzt: Rückmeldungen, die Aufmerksamkeit von der Aufgabe weg auf die Person lenken, können Leistung mindern; kriterienfokussierte, aufgabennahe Impulse sind überlegen.[18]

Designprinzipien wirksamer Rückmeldung

Aus diesen Fundierungen ergeben sich klare Gestaltungsprinzipien für Unterricht und Materialentwicklung. Erstens verlangt wirksames Feedback eine transparente Ziel- und Kriterienarbeit: Lernende müssen wissen, woran Qualität erkennbar ist; Beispiele und Gegenbeispiele helfen, Kriterien zu operationalisieren. Zweitens sollten Hinweise sich auf beobachtbare Merkmale beziehen, nicht auf Intuitionen – etwa auf Textstruktur, Argumentationsqualität, Belegführung, Rechenwege oder Messprotokolle. Drittens gilt das Prioritätsprinzip: Ein einziger nächster Schritt ist oft produktiver als fünf gleichzeitige Forderungen. Viertens ist Zeitnähe zentral: Je kürzer die Lücke zwischen Handlung und Rückmeldung, desto höher die Umsetzungswahrscheinlichkeit. Fünftens schließt jeder Zyklus mit einer sichtbaren Überarbeitung und einem kurzen Reflexionsimpuls (Was wurde geändert? Warum? Welche Evidenz stützt die Änderung?). Eine kompakte Heuristik lautet:

- Ziel und Kriterium benennen

- beobachtbare Evidenz anführen

- genau einen nächsten Schritt priorisieren

- Änderung dokumentieren. Diese Logik entspricht dem Dreischritt Feed Up – Feed Back – Feed Forward und wird in Übersichtsarbeiten zu formativer Beurteilung breit gestützt.[19][20]

Aufgabenqualität als Dreh- und Angelpunkt

Aufgaben sind der Motor jeder Feedbackkultur. Sie definieren den Erkenntnisraum, in dem Kriterien bedeutsam werden, und erzeugen die natürlichen „Ankerpunkte“ für Rückmeldungen. Gute Aufgaben erzwingen Denken statt bloßer Reproduktion, lassen verschiedene Lösungswege zu und enthalten eingebettete Checkpunkte, an denen Zwischenstände sinnvoll überprüft werden können. Eine robuste Progression besteht aus drei Phasen: In der Verstehensphase werden Konzepte geklärt und diagnostische Kurzaufgaben genutzt, um Fehlvorstellungen sichtbar zu machen; in der Anwendungsphase wird mit Kriterien gearbeitet, die Qualität von Produkten oder Problemlösungen messbar machen; in der Transferphase wird das Gelernte auf neue Kontexte übertragen. Digitale aiMOOCs erleichtern diese Architektur, indem sie Sofort-Rückmeldungen für formale und grundlegende Aspekte bereitstellen (z. B. Format, Struktur, Basiskorrektheit), während anspruchsvollere Qualitätsmerkmale (z. B. Argumentationslogik, empirische Angemessenheit, Modellgüte) über Peer-Dialoge, Mentoring, KI-Impulse und Lehrkraft-Feedback adressiert werden.[21][22] Aus Sicht der kognitiven Belastung bewähren sich dabei kleinschrittige Aufgabenketten, Beispiel–Gegenbeispiel-Paare und fokussierte Kriterienraster, die extrinsische Belastung reduzieren und die aufgabenrelevante Verarbeitung stärken.[23]

Prozessarchitektur eines lernwirksamen Zyklus

Ein zielführender Feedbackzyklus in FELIX beginnt mit einer kurzen Ziel- und Kriterienklärung, die nicht nur verbal, sondern mit Artefakten (Beispiel, Gegenbeispiel, Kurzrubrik) abgesichert wird. Es folgt ein Erstentwurf oder eine Erstlösung; eingebettete Systemhinweise (z. B. im aiMOOC) prüfen formale Mindeststandards. Darauf baut eine dialogische Sequenz auf: ein kurzer, kriteriengeleiteter Peer-Austausch mit einer priorisierten Empfehlung; bei Bedarf ein 10–15-minütiges Mentoring-Fenster für strukturierende Unterstützung; anschließend ein KI-Impuls zu genau einem fokussierten Aspekt (z. B. Klarheit von Definitionen, Kohärenz eines Beweisschrittes, Angemessenheit einer Datenvisualisierung); schließlich das Meta-Feedback der Lehrkraft, das gewichtet, priorisiert und auf Transferchancen hinlenkt. Jede Rückmeldestufe endet mit einer konkret geplanten Änderung, die im Lernjournal dokumentiert wird (Ziel – Hinweis – Aktion – Evidenz – Reflexion). Diese Architektur verbindet hohe Frequenz mit kognitiver Steuerbarkeit und macht Fortschritt sichtbar.[24][25]

Rollen und geteilte Verantwortung in FELIX/FIX

FELIX verteilt Verantwortung auf fünf Rollen, die sich ergänzen und gegenseitig absichern. Lernende sind aktive Akteure: Sie bringen Ziele, Zwischenstände und Belege ein, entscheiden mit, welchen Hinweis sie zuerst umsetzen, und dokumentieren ihre Änderungen. Peers steigern die Dichte und Vielfalt von Rückmeldungen; richtig angeleitet, erhöhen sie die Kriteriensensibilität der ganzen Lerngruppe und professionalisieren die Sprache des Feedbacks.[26][27] Mentor:innen bieten über das Peer-Niveau hinaus strukturierende Kurzinterventionen in der ZPD; sie helfen, Denkwege zu ordnen, ohne Lösungen vorzugeben.[28] KI-Assistenten liefern hochfrequente, kriteriennahe Impulse, generieren Beispiele, prüfen Formate und schlagen nächste Schritte vor – stets gekennzeichnet, fachlich geprüft und in didaktische Routinen eingebettet.[29] Die Lehrkraft fungiert als Xpert: Sie priorisiert, gewichtet und rahmt, sorgt für Anschluss an Standards, Fairness, Datenschutz und Barrierefreiheit und behält den langfristigen Kompetenzaufbau im Blick.[30]

KI als Verstärker: Potenziale, Grenzen und Leitplanken

KI kann diagnostische Präzision und Rückmeldefrequenz deutlich erhöhen. Sie erkennt Muster in Texten, Rechnungen oder Messdaten, generiert Vergleichsbeispiele und operationalisiert Kriterien, etwa indem sie typische Fehlerschritte markiert und Alternativen aufzeigt. Doch gerade weil KI leistungsfähig ist, braucht sie pädagogische Leitplanken: Transparenz über ihren Einsatz (Kennzeichnung, Quellenlage), fachliche Prüfung kritischer Hinweise, Datensparsamkeit und klare Speicherfristen, Bias-Achtsamkeit (z. B. Diversitätschecks bei Beispielen) sowie barrierearme Formate. Ein kompetenzbasiertes Zugangsmodell – Vertrauensstufen – stellt sicher, dass Lernende Funktionen schrittweise freischalten, wenn sie zeigen, dass sie Feedback verantwortungsvoll nutzen (z. B. nach bestandenem Tablet- und KI-Führerschein).[31] So wird KI zum Verstärker einer bereits tragfähigen Feedbackkultur – nicht zu deren Ersatz.

Häufige Missverständnisse und Gegenstrategien

Drei verbreitete Missverständnisse behindern wirksame Rückmeldungen. Erstens: Mehr ist besser. Empirisch belastbar ist das Gegenteil – wenige, priorisierte Hinweise mit hohem Umsetzungsgrad schlagen umfangreiche Kommentarlisten.[32] Zweitens: Lob genügt. Wertschätzung ist wichtig, ersetzt aber keine kriteriengeleitete Anleitung zur Verbesserung. Drittens: Die KI macht es schon. Ohne didaktische Rahmung, Kriterienklarheit und eine verbindliche Überarbeitungsphase produziert selbst gute KI-Rückmeldung kaum Lerngewinn. Gegenstrategien sind transparente Kriterienarbeit, kurze, planbare Schleifen, explizite Überarbeitungsaufträge, Lernjournale sowie eine systematische Schulung in Feedback-Literacy, damit Lernende Rückmeldungen verstehen, bewerten und in Handlungen überführen können.[33]

Übergang zu Teil II

Die in Teil I entwickelten Prinzipien bilden das Fundament für das Modell FELIX. In Teil II werden die fünf Stufen – Free Learning, Evaluation, Learning Mentor, Interactive Feedback und Xpert – im Detail entfaltet. Jede Stufe erhält klare Ziele, typische Inputs und Outputs, Qualitätskriterien, wiederkehrende Routinen sowie konkrete Gegenmittel gegen häufige Fehlsteuerungen. Zugleich wird die Kurzform FIX erläutert, die – wo Ressourcen fehlen oder Passung nicht gegeben ist – die Logik von Ziel – Diagnose – nächster Schritt mit drei Stufen aufrechterhält.

Teil II: Das Modell FELIX im Detail

F – Free Learning (aiMOOCs mit Sofort-Feedback)

Ziel und didaktische Logik. Free Learning ist das Eingangstor der FELIX-Architektur. Lernende arbeiten selbstgesteuert in strukturierten, offen zugänglichen Lernkursen (aiMOOCs), die Inhalte, Aktivitäten und unmittelbar wirksame Mikrorückmeldungen verbinden. Die Stufe F schafft einen verlässlichen Grundtakt: Vor jeder sozialen oder professionellen Rückmeldung wird Basisqualität hergestellt (Form, Struktur, elementare Richtigkeit). Dadurch werden spätere Feedbackressourcen (Peers, Mentor:innen, Lehrkraft) entlastet und können sich auf höherwertige Qualitätsmerkmale konzentrieren – Argumentationslogik, Problemstrategien, Modellgüte. Diese Vorstrukturierung entspricht der Einsicht, dass kurze, häufige und kriteriennahe Rückmeldeschleifen die lernwirksamsten sind.[34][35]

Struktur und Ablauf. Ein aiMOOC beginnt mit einer expliziten Ziel- und Kriterienklärung, illustriert durch Beispiel und Gegenbeispiel. Es folgt eine Folge kleiner Aufgaben, die jeweils einen eingebetteten Check enthalten (z. B. Formatprüfung, Strukturhinweis, grundlegende Richtigkeitskontrolle). Lernende erhalten sofortige, knappe Mikrohints, setzen eine Mini-Revision um und dokumentieren diese im Lernjournal (Ziel – Hinweis – Aktion – Evidenz). Auf diese Weise entstehen beobachtbare Spuren des Lernens, die in den Folgestufen (E, L, I, X) aufgegriffen und verdichtet werden. Die aiMOOC-Umgebung eignet sich dafür, weil sie Interaktion, offene Publikation und differenzierbare Pfade verbindet.[36][37]

Qualitätskriterien und Heuristiken. Wirksam ist F, wenn Kriterien sichtbar und operationalisiert sind, Aufgabenprogression kleinschrittig verläuft und Mikrohints strikt auf ein Merkmal zielen. Eine kompakte Heuristik lautet:

- Kriterium zuerst sichtbar machen

- maximal zwei Mikrohints pro Aufgabe

- genau ein nächster Schritt

- Mini-Revision mit Evidenz. Diese Fokussierung schont Arbeitsgedächtnisressourcen und erhöht die Wahrscheinlichkeit, dass Hinweise umgesetzt werden.[38]

Häufige Fehlsteuerungen und Gegenmittel. Typische Probleme sind überfrachtete Aufgaben, unklare Kriterien oder zu lange Hints. Gegenmittel sind eine klare Kriterienkarte am Aufgabenbeginn, Beispiel–Gegenbeispiel-Paare, strikte Längenbegrenzung für Hints und verpflichtende Mini-Revisionen. F dient nicht der Vollkorrektur, sondern der Basisstabilisierung; alles Weitere folgt in E, L, I, X.

Dokumentation und Anschluss. Jede Aufgabe erzeugt eine kurze Spur im Lernjournal. Diese Dokumentation erlaubt späteren Rollen (Peers, Mentor:innen, Lehrkraft), gezielt dort einzusetzen, wo der Lernprozess stockt, und verhindert redundante Rückmeldungen.

E – Evaluation (Peer-Feedback)

Ziel und didaktische Logik. Evaluation ist kriteriengeleitetes Peer-Feedback als strukturierte, soziale Qualitätsprüfung. Sie erweitert Perspektiven, trainiert Feedback-Literacy und verankert die Sprache der Kriterien im Klassenraum. Dabei ersetzt sie keine Bewertung, sondern liefert handlungsleitende Entwicklungshinweise. Das dialogische Moment ist zentral: In der ko-konstruktiven Auseinandersetzung über Belege und Qualitätsmerkmale verdichten Lernende ihr Verständnis von „guter Arbeit“. Forschung zeigt, dass Peers – gut angeleitet – sowohl Leistung als auch Metakognition positiv beeinflussen können.[39][40]

Struktur und Ablauf. Nach F bringt jedes Team ein Zwischenprodukt mit klar benannter Ziel-Kriterium-Kombination ein. Peers prüfen an genau diesem Fokus, benennen eine evidenzbasierte Stärke und einen priorisierten nächsten Schritt, der in der verfügbaren Zeit realistisch ist. Der Austausch ist zeitlich knapp gehalten und folgt Satzstartern („Ich sehe Kriterium X belegt in …; ein nächster Schritt wäre …, weil …“). Anschließend setzen Lernende einen einzigen Verbesserungsschritt um und dokumentieren ihn.

Qualitätskriterien und Heuristiken. Qualität entsteht über Fokussierung, Sprachstützen und Evidenzpflicht. Eine verdichtete Heuristik lautet:

- ein Kriterium

- ein Beleg